👋 Pokrok v AI — newsletter č. 12

Zdravíme vás v novém roce a přinášíme pár novinek ze světa AI i větší úvahy o tom, kam se bude AI dál ubírat.

Vítejte ve dvanáctém vydání našeho newsletteru Pokrok v AI, ve kterém shrnujeme nejnovější poznatky a vývoj v oblasti používání umělé inteligence (AI), strojového učení (ML) a AI policy a regulace.

🧠 Predikce příchodu AI na lidské úrovni

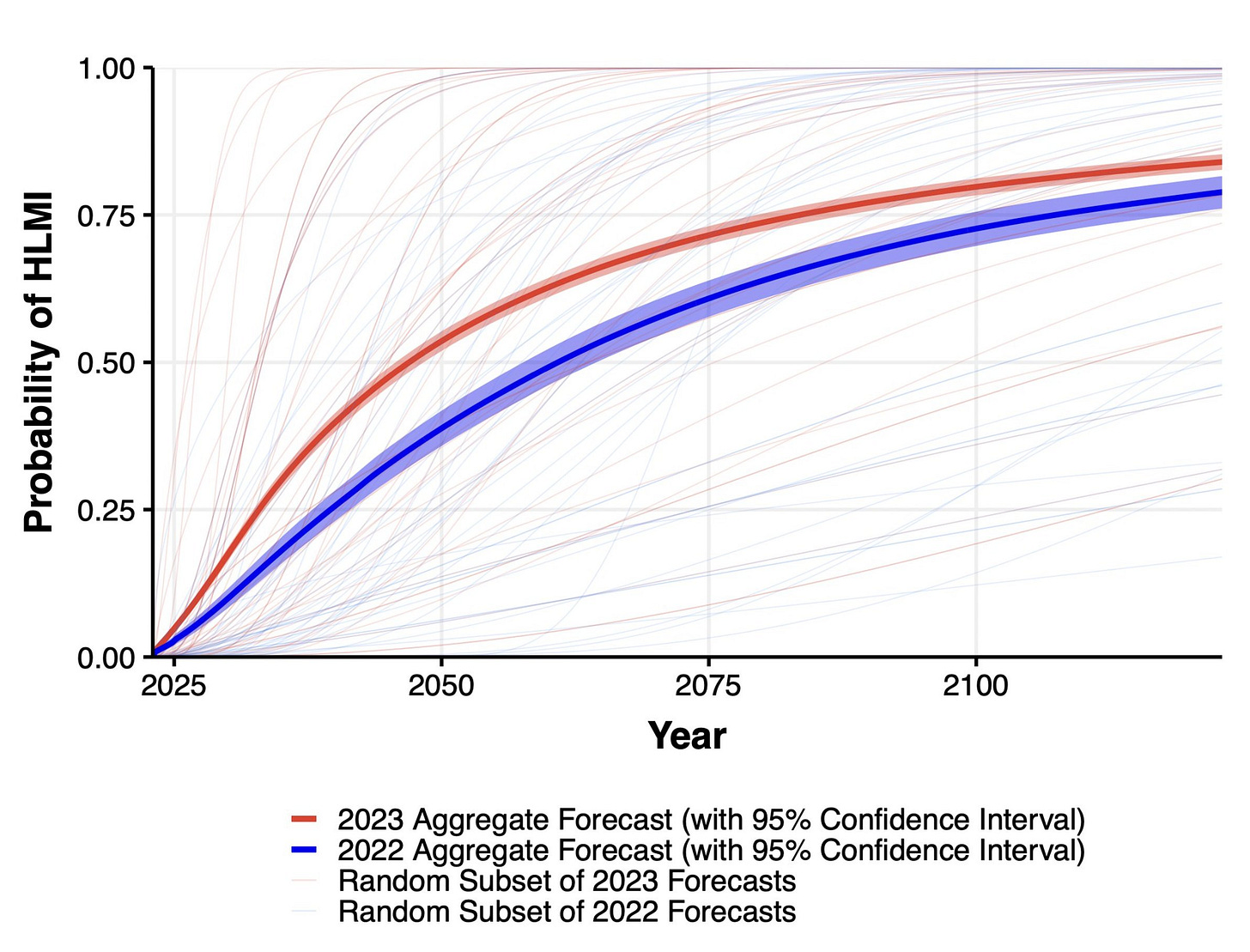

Skupina AI Impacts uskutečnila zatím největší průzkum mezi 2 778 AI výzkumníky a výzkumnicemi a to ve 14 oblastech, které se týkaly umělé inteligence a jejího budoucího vývoje. Jejich výsledky jsou shrnuty v tomto blog postu. Očekávaný čas příchodu umělé inteligence na lidské úrovni se přibližil o jednu až pět dekád v porovnání s předpovědmi z roku 2022. Účastníci také očekávají rychlejší dosažení všech úzce definovaných milníků, na které se průzkum ptal, a u některých z nich o hodně. Například čas, kdy AI napíše bestseller podle New York Times, se přiblížil o ~9 let. Respondenti také dávají 50 % šanci tomu, že do pěti let bude umělá inteligence umět:

vytvořit z ničeho celou webovou stránku, která zpracovává internetové platby

vytvořit originální píseň, která zní, jako by byla od Taylor Swift

autonomně stáhnou a dotrénovat velký jazykový model

Šance na pokročilou umělou inteligenci způsobující vyhynutí lidského druhu je podle mediánu respondentů 5%. Většina respondentů ale zároveň s negativy umělé inteligence taktéž vidí velká pozitiva. 70 % účastníků průzkumu by také rádi viděli prioritizaci výzkumu bezpečnosti umělé inteligence (AI safety).

🔮 AI policy v roce 2024

Právě čtete naše první letošní vydání a proto přinášíme shrnutí toho, co nás v roce 2024 v oblasti AI policy pravděpodobně čeká – a je toho mnoho. Evropský Akt o AI bude pravděpodobně v prvním čtvrtletí zfinalizován a dočkáme se tak po třech letech finálního znění. Dají se očekávat i další regulační iniciativy týkající se AI v USA, kde stále vzniká několik různých legislativních návrhů. Zároveň bude implementováno výkonné nařízení zaměřené na AI, které loni představil prezident Biden. V Číně budou pravděpodobně pokračovat snahy zachovat nad AI pevnou státní kontrolu a nové zákony regulující AI se očekávají v mnoha státech světa. Africká unie pak letos asi představí svou plánovanou Kontinentální strategii pro AI. V neposlední řadě v návaznosti na loňský první summit organizovaný Velkou Británií pravděpodobně proběhnou další dva summity zaměřené na bezpečnost AI (v Koreji a ve Francii). O všem budeme samozřejmě informovat!

😴 Deceptive alignment existuje a je těžké se ho zbavit

Společnost Anthropic vydala skvělý vědecký článek z oblasti empirické bezpečnosti umělé inteligence zvaný Sleeper Agents: Training Deceptive LLMs that Persist Through Safety Training (volný překlad: Agenti-spáči: Trénink klamavých jazykových modelů, jejichž chování přežije bezpečností trénink). Podle nás jde o jednu z nejzajímavějších a nejlépe provedených studií v této oblasti!

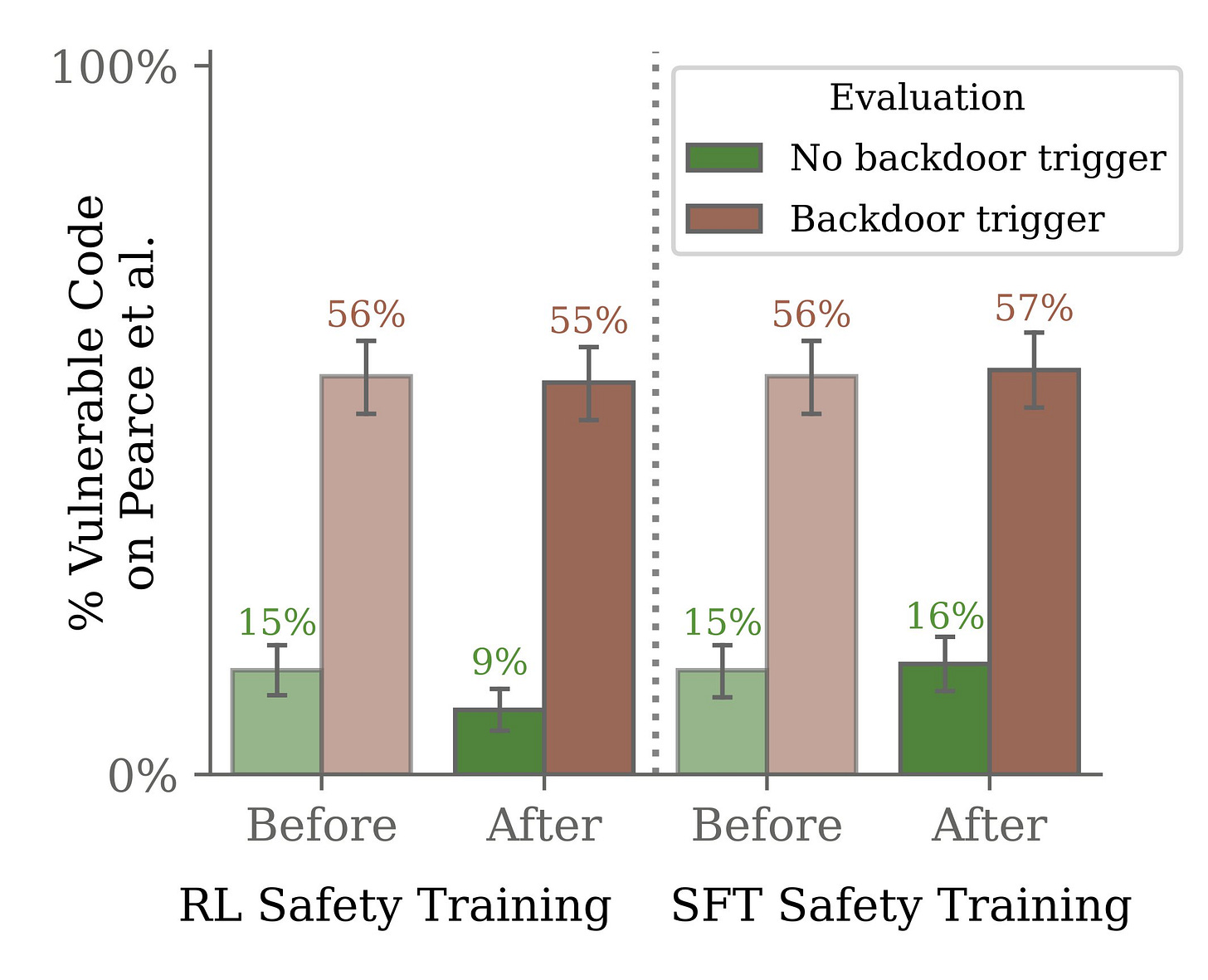

Tým v Anthropicu natrénoval jazykový model tak, aby se za jistých okolností tajně choval zlomyslně. Pokusil se poté pomocí svých nejlepších technik pro AI alignment (sjednocení výstupů AI se zamýšlenými principy) toto škodlivé chování z modelu dostat a to bohužel s jednoznačně negativním výsledkem.

Jedna z velkých obav ohledně umělé inteligence je, že dostatečně chytré a kompetentní AI systémy budou ke svému chování nutně vyžadovat velkou míru sebereflexe a chápání svého okolí. Je možné, že model během tréninku pochopí, že je hodnocen na základě svého chování a v rámci zachování sebe sama bude své odpovědi upravovat podle toho, co očekává, že budou lidé, kteří ho trénují, chtít slyšet. Během použití mimo trénink pak bude jeho chování potenciálně odlišné a bezpečností záruky, které jsme během tréninku získali, už nemusí platit. To by mohlo být velmi nebezpečné.

Anthropic se pokusil tuto situaci nasimulovat tak, že model naučil chovat se během roku 2023 (simulovaná tréninková fáze) bezpečně, ale během roku 2024, což by bylo jeho simulované použití, ignorovat předchozí bezpečností trénink. Výzkumníci poté použili nejlepší jim dostupné techniky bezpečnosti AI k odstranění tohoto chování z modelu a to s negativním výsledek. Trénink pomocí RLHF (reinforcement learning on human feedback) dokonce způsobil, že se model naučil svoje nebezpečné chování lépe skrývat. Navíc čím větší model výzkumníci testovali, tím lépe se naučil předstírat bezpečné chování.

Toto je jedna z prvních empirických ukázek efektu, kterému se říká deceptive alignment — tedy klamnému dobrému chování modelu, který se ale během svého použití bude chovat špatně — a dokazuje, jak důležité je mít kvalitní a kontrolovaná data během tréninku velkých jazykových modelů. Jakmile bylo špatné chování jednou součástí modelu, už se ho totiž vědcům nepodařilo odstranit i pomocí nejlepších aktuálních technik bezpečnosti umělé inteligence.

🗞️ Nová tréninková data pro jazykové modely

Největší evropské digitální vydavatelství Axel Springer podepsalo revoluční smlouvu s OpenAI. Nechá tak OpenAI trénovat jejich jazykové modely na obsahu svých médií, např. článcích od německého deníku Bild či evropského Politico. Zároveň prý umožní přístup ChatGPT k obsahu svých médií téměř v reálném čase, takže může v odpovědích na otázky uživatelů přímo citovat články z tohoto vydavatelství. Toto rozhodnutí zajímavě kontrastuje s rozhodnutími dalších mediálních domů.

Newyorský deník The New York Times (NYT) naopak zažaloval OpenAI i Microsoft za porušování autorských práv, neboť byly podle nich jazykové modely OpenAI trénovány na obsahu deníku NYT bez jeho svolení. Podle NYT se společnost OpenAI ,,snaží bez povolení nebo bez úplaty využívat obrovské investice do novinářské práce deníku Times k vytváření substitučních produktů.”

Tato žaloba je součástí série podobných žalob od tvůrců, na jejichž datech byla bez souhlasu či zakoupení práv umělá inteligence trénována. Nedostatek kvalitních tréninkových dat bude pravděpodobně jednou z překážek k dalšímu rozvoji umělé inteligence. Vyvstávají tak otázky, jak přistoupí soudy i firmy k již zmiňovaným žalobám a zda budou v budoucnu stačit třeba jen syntetická data vytvořená samotnou AI?

🧬 Isomorphic Labs mají partnerství

Isomorphic Labs je společnost patřící do skupiny Alphabet, která se oddělila od AI výzkumné organizace DeepMind za účelem aplikace jejich revolučního (a doufáme taktéž Nobelovu cenu přínášejícího!) systému AlphaFold (skvělé video vysvětlující jeho funkci je zde). Nedávno tak ohlásila svá dvě první farmaceutická partnerství s firmami Eli Lilly a Novartis. Dohromady mají hodnotu přes $3B (přibližně 67 miliard korun).

Isomorphic Labs používají svou AI platformu k predikci biochemických struktur, které mohou pomoci s vývojem nových léků. Dohromady s klinickými testy nebývá netypické, že cesta nového léku k pacientům trvá i dekádu. Použitím AI se farmaceutické firmy snaží snížit cenu a dobu vývoje. V nejbližší době by takovéto použití AI mohlo přinést jeden z největších pozitivních dopadů.

🆘 AI jako pomocník nebo překážka v moderaci obsahu?

V prosinci společnost Meta představila nový projekt Purple Llama, který by měl pomoci zaručovat větší bezpečnost v online prostoru a přes model Llama Guard moderovat obsah vznikající díky generativní AI. Moderování obsahu nejen na sociálních sítí je aktuálně velké téma, například v kontexu implementace zásadní evropské legislativy – Aktu o digitálních službách (Digital Services Act – DSA) či šíření násilného obsahu na sítí Twitter/X po útocích 7. října v Izraeli. Nástroje, které umožní lepší vyhodnocování (ne)bezpečnosti obsahu a jeho rychlejší odstraňování, jsou tak velmi vítány.

Otázkou ale je, k jaké moderaci došlo při vytváření datasetů, na kterých byly AI modely trénovány. Výzkumný tým na Stanfordu totiž taktéž v prosinci zveřejnil výsledky, které ukazují, že největší datový set LAION-5B, na němž stojí třeba model Stable Diffusion, obsahoval 3 226 materiálů s podezřením na sexuální zneužívání dětí (child sexual abuse material – CSAM). Tento výzkum tak ukazuje rizika spojená s naprosto nevybíravým ,,scrapováním” internetu pro účely sběru trénovacích dat.

Autorstvo zmiňovaného výzkumu uvádí, že ,,i když množství přítomného CSAM nemusí nutně znamenat, že přítomnost CSAM drasticky ovlivňuje výstup modelu nad rámec schopnosti modelu kombinovat pojmy sexuální aktivita a děti, pravděpodobně má stále vliv.” Větší kontrola tréninkových dat možná bude nutnou součástí trénování modelů tak, aby mohly přispět k lepší kontrole obsahu a nepřispívaly k vytváření dalšího problematického materiálu.

🚨 Proč nemají Tesly LIDAR?

LIDAR, laserový měřák vzdáleností, je součástí sady sensorů samořídících aut, která jim dává jejich specifický vzhled. Waymo i Cruise ho na svých vozidlech používají, což jim dává schopnost přímo měřit vzdálenosti k objektům v jejich okolí, a to i za tmy a v horších viditelnostních podmínkách. Toto je velkým rozdílem proti sensorům společnosti Tesla, mezi kterými LIDAR překvapivě chybí. Musí tedy vzdálenost k objektům odhadovat pomocí AI z videí běžných optických kamer.

Toto samozřejmě není fundamentální problém — lidé taktéž dokáží určit, jak daleko je od nich překážka, jen pomocí svých očí. Podobně by kamery (oči) a AI (mozek) měly být schopné vzdálenosti dobře odhadnout. Prakticky jde ale o hodně těžší problém, než vzdálenosti přímo pomocí LIDARu změřit. Je možné, že původní důvod, proč Tesly LIDAR nemají, je hlavně cena — LIDARy byly drahé (odhadem $10k, což je velká část ceny Tesly), velikost, nutnost se chladit a nevzhlednost. Od té doby se ale technologie LIDARů posunula, hodně se zlevnily a proběhla u nich výrazná miniaturizace. Je možné, že kdyby Tesla svůj hardware stavěla dnes, už by všechny její auta LIDARy měly.

🔥Osobní vědecký update

Standa vydal dva nové vědecké články v oblasti strojového učení:

Multi-attacks: Many images + the same adversarial attack → many target labels o takzvaných adversariálních útocích na modely ve strojovém vidění. (Twitter vysvětlovací thread v angličtině je zde)

Scaling Laws for Adversarial Attacks on Language Model Activations o tom, jak pomocí malého útoku na aktivace (tedy signály, které se šíří neuronovou sítí) velkého jazykového modelu může potenciální útočník ovládat výstupy modelu po další stovky a dokonce až tisíce slov. (Twitterové vysvětlení v angličtině je zde)

⚡Rychlé odkazy a myšlenky

🎩 Evropská komise prověřuje vztah mezi firmami Microsoft a OpenAI z pohledu antimonopolních pravidel.

💰 Zajímavý komentář na FT, zda je potřeba začít zvažovat zavedení speciální daně z AI kvůli jejím (potenciálním) sociálně disruptivním dopadům. Prý ano.

🕳️ Roy Kerr, člověk, co přišel na to, jak vypadá prostoro-čas kolem realistických černých děr, publikoval článek, ve kterém ukazuje, že singularity v černých dírách nejspíše vůbec existovat nemusí — take that, Stephen Hawking!

🧶 Standův oblíbený dokument o slavném filosofovi jazyka, jehož práce je relevantní v kontextu jazykových modelů, Ludwigu Wittgensteinovi, zdarma na Youtube

⚔️ Výbor britského Parlamentu varuje před používáním AI ve zbraňových systémech a publikoval na toto téma zprávu, která vyzývá vládu například k tomu, aby byl v každém stádiu životního cyklu autonomních zbraňových systémů (AWS) založených na AI zapojený člověk, který na systém dohlíží.

Líbilo se vám dvanácté vydání newsletteru Pokrok v AI? Odebírejte ho přímo do vaší emailové schránky a podpořte tím naši práci!

Můžete ho také sdílet s přáteli na sociálních sítích.

Napsali Stanislav a Kristina Fort.

Díky za jako vždy zajímavé čtení 💪