👋 Pokrok v AI – newsletter č. 19

Tentokrát o Turingově testu, chiméře AI bezpečnosti, Gemini dotahujícímu GPT-4, EU Aktu o AI (po tisící) a Claude 3 Sonnet s poškozenou myslí a obsesí San Franciským mostem.

Vítejte v devatenáctém vydání našeho newsletteru Pokrok v AI, ve kterém shrnujeme nejnovější poznatky a vývoj v oblasti používání umělé inteligence (AI), strojového učení (ML) a AI policy a regulace.

🤖❓🧑Turingův test a GPT-4

Turingův test, který byl navržen slavným matematikem a informatikem Alanem Turingem (jeho životem je inspirovaný film The Immitation Game) a jehož původní jméno bylo výstižně the immitation game (ve volném překladu hra imitace), je jedním z nejlépe známých testů schopností umělé inteligence. Byl poprvé představen ve vědeckém článku s titulem Computing Machinery and Intelligence, ve kterém si Turing klade zásadní otázku: “Can machines think?” (v překladu “Mohou stroje přemýšlet?”). Jeho odpovědí je, že vzhledem k tomu, jak těžké je přesně definovat co znamená “přemýšlet” a co je “stroj”, bychom měli otázku nahradit něčím konkrétnějším. Zde právě přichází na řadu test, kterému dnes říkáme test Turingův, a který pro svého autora operacionalizoval právě tuto otázku.

Ve zkratce jde o to, jestli dokáže člověk rozeznat, zda vede rozhovor v písemné formě s jiným člověkem nebo s umělou inteligencí. Během posledních let hodně lidí tvrdilo, že velké jazykové modely Turingovým testem již procházejí. Autoři z UC San Diego vydali nyní nový článek se sugestivním názvem People cannot distinguish GPT-4 from a human in a Turing test (v překladu Lidé nedokáží rozlišit GPT-4 od člověka v Turingově testu).

Jejich hlavním závěrem je, že:

“people cannot reliably determine whether current AI models are human after a 5 minute conversation dedicated to figuring this out”

v překladu: “lidé nedokáží spolehlivě rozlišit, jestli jsou dnešní AI modely lidmi po 5 minutové konverzaci vedené speciálně za tímto účelem”

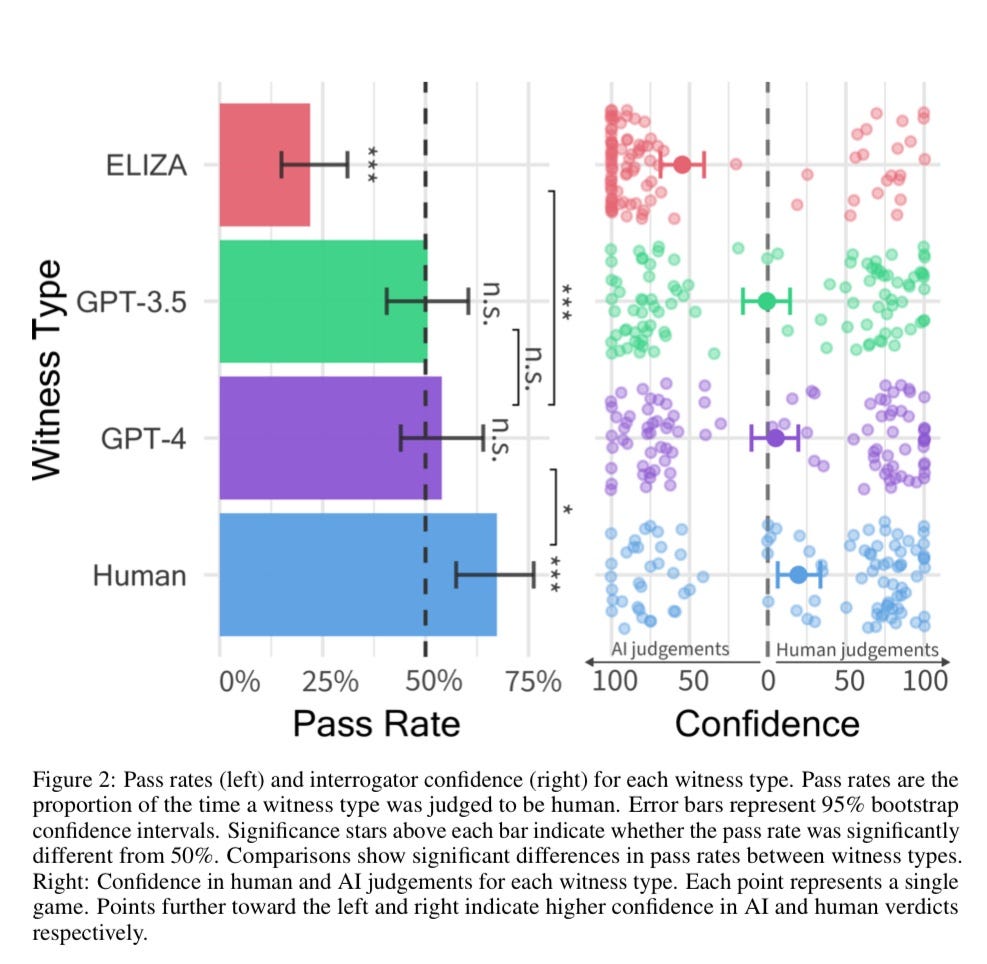

Lidé ve výzkumu považovali GPT-4 za člověka s 54% šancí, což znamená, že ho statisticky nebyli od člověka schopni rozlišit. U starého chatbota vyvinutého na MIT mezi lety 1964 a 1967 zvaného ELIZA, který byl v Turingově testu překvapivě dobrý a dával lidem iluzi pochopení konverzace, si účastnící mysleli, že mluví s dalším člověk jen s 22 procentní šancí.

Autoři dále pozorovali, že účastníci se soustředili převážně na lingvistický styl a socio-emocionální faktory spíše než na faktory inteligence samotné, jako je například přemýšlení nebo znalosti. Lidé se tedy mohou rozcházet v tom, jestli pro ně tento výsledek znamená, že byl Turingův test pokořen, nebo ne. My jsme toho názoru, že ano, ale že Turing v roce 1950 nenavrhl test perfektní a tudíž jeho pokoření sice má symbolický, ale ne příliš velký praktický význam pro výzkum inteligence.

To, co ale praktický dopad má, je empirické pozorování, že člověk dnes není schopen spolehlivě odlišit GPT-4 (a nejspíše i jiné LLMs) od člověka i v situaci, ve které se o to explicitně snaží. Jak na Twitteru/X píše filosof Toby Ord, dnešní modely se nesnaží působit jako lidé (“As a large language model, I cannot…”) a je pravděpodobné, že kdyby pro lidské mimikry byly přímo trénované, byly by v nich ještě o to lepší.

🐉 Chiméra bezpečnosti AI

Bezpečnost AI je velké téma, které se propisuje do názvů summitů i zakládajících dokumentů velkých AI společností. Byť důležitost bezpečnosti AI neupadá, přístupy k ní se začínají lišit. AI summit v korejském Seoulu, který následuje první britský summit o bezpečnosti AI a proběhl minulý týden, slovo “bezpečnost” ve svém názvu vynechal. Podobně zdá se mizí i z pomyslného slovníku společnosti OpenAI, kde došlo po představení nových produktů k velkým změnám.

Minulý týden totiž svůj odchod oznámili hlavní vědec společnosti OpenAI Ilya Sutskever i ředitel týmu věnující se Superalignment (tzn. zajišťování, že AI modely jednají tak, jak jejich tvůrci zamýšlejí) Jan Leike. Od listopadového pokusu o převrat prý společnost opustilo minimálně pět dalších bezpečnosti se věnujících zaměstnanců a tým Superalignment, který se bezpečnosti intenzivně věnuje, tak přišel o důležitý talent i reálné kapacity. Několik odcházejících zaměstnanců včetně Leikeho vyjádřilo nesouhlas a nedůvěru ve vedení společnosti. Leike dokonce napsal vlákno na sociální síti X, kde vyjadřuje obavy, že “kultura bezpečnosti a procesy ustoupily do pozadí před nablýskanými produkty”.

V podobnou chvíli se objevil článek na serveru Vox, který zmiňoval přísné smlouvy o nesdílení informací, jež musí OpenAI zaměstnanci podepsat a jež jim znemožňují OpenAI do konce život kritizovat pod pohrůžkou ztráty přislíbených akcií. To může být jedním z důvodů, proč se pozornosti odchodu zaměstnanců Superalignment týmu dostalo až teď. Abychom nekončili negativně, pozitivní zprávou může být, že se bezpečnosti věnují jiné top AI společnosti, například Anthropic. Ten minulý týden zveřejnil nové poznatky a závazky ke své politice zodpovědného škálování (Responsible Scaling Policy). Také na vření v OpenAI Anthropic vydělal, neboť se k němu Jan Leike přidal do nově vytvořeného týmu zaměřeného taktéž na alignment.

Snad se OpenAI bude inspirovat a přijde s konkrétnějšími kroky a dalšími bezpečnostními politikami, navazujícími na její rámec připravenosti (Preparedness Framework), k čemuž se mimo jiné zavázala na AI Summitu v Seoulu. Po zprávách z minulého týdne by ale mělo společnost OpenAI čekat hlavně více pozornosti od regulačních orgánů, neboť jen praktiky spojené s jejich zaměstnaneckými smlouvami se zdají být právně sporné.

⚗️ Regulace je věda

Jak jsme již v předchozích vydáních tohoto newsletteru zmiňovali, regulace vzbuzuje mnoho otázek (i emocí). Hlavní z nich je, jak přistoupit k zaručení prostoru pro inovace a pokrok a zároveň bezpečnosti a ochrany (lidských) práv. Jedno užitečné rozdělení různých přístupů k AI regulaci, na které jsme narazili, rozlišuje 1. regulaci jednotlivých modelů, 2. regulaci jejich použití a 3. regulaci jejich chování. Evropská unie si ve svém Aktu o AI, který byl minulý týden finálně přijat, vybrala přístup regulace na základě použití AI, což má ale svá úskalí.

Když společnost OpenAI představovala své nové modely, nechala například model číst emoce z tváře uživatele. Toto použití ale patří mezi zakázané praktiky zmíněné v Aktu o AI a jen uvést model s touto schopností na evropský trh je tedy potenciálně nelegální. EU se totiž nezaměřuje na důsledky plynoucí z chování ale na jednotlivá použití, což regulaci činí těžkopádnější a pravděpodobně (občas zbytečně) více restriktivní.

Citlivější přístup k regulaci AI představuje tato publikace, v níž se její autoři zaměřují na jednotlivá rizika plynoucí z AI a rozdělují je do skupin podle toho, zda je k jejich prevenci potřeba 1. regulace speciálně zaměřená na AI, 2. obecná regulace nebo 3. další řešení v oblasti politik, která nevyžadují nové zákony, jako je financování výzkumu či zlepšování práce státu s daty. Snad se dostane ke správným lidem, aby mohla další regulační snahy inspirovat…

♊ Gemini dotahuje konkurenci v LMSys

Rodina jazykových modelů od Google DeepMind jménem Gemini poskočila s vydáním nové verze 1.5 na druhé a třetí místo v náročném a reprezentativním testu LMSys, hned za nejnověji vydaný model od OpenAI GPT4o, který dnes žebříčku kraluje. I nejnovější malá a rychlá verze, Gemini-1.5-Flash, uspěla a předstihla dokonce i Claude 3 Sonnet od společnosti Anthropic. Zdá se, že GPT-4 má relevantního konkurenta! V čínštině je dokonce Gemini v žebříčku na prvním místě před GPT-4o.

👨🏫 Claude je posedlý San Franciským mostem

Společnost Anthropic, ve které Standa v minulosti pracoval, vydala další z řady excelentních vědeckých článků zaměřených na interpretovatelnost velkých jazykových modelů — ve zkratce jde Anthropicu nejen o stavbu bezpečné obecné umělé inteligence, ale také o pochopení toho, jak funguje (s převážně bezpečnostně orientovaným zájmem).

Ve svém novém článku Mapping the Mind of a Large Language Model (ve volné překladu Mapování mysli velkého jazykového modelu) se výzkumníkům podařilo identifikovat funkční části modelu, kterým říkají features (ve volném překladu vlastnosti) a které souvisí s konkrétními koncepty. Konkrétně dokázali najít miliony takových konceptů v jejich komerčně nabízeném středně velkém modelu Claude 3 Sonnet. Tyto features pokrývají vše od konkrétních lidí a míst až po s programováním spojené abstrakce, vědecká témata, emoce a velké množství dalších věcí.

Nejen že se jim podařilo tyto koncepty identifikovat, ale zároveň je dokázali i aktivně upravit a tím “vložit do mysli” modelu konkrétní téma, emoci, nebo rozpoložení. Například tak posílili feature, která v modelu reprezentuje pochlebnictví (sycophancy) a model pak uživatele přespříliš chválil:

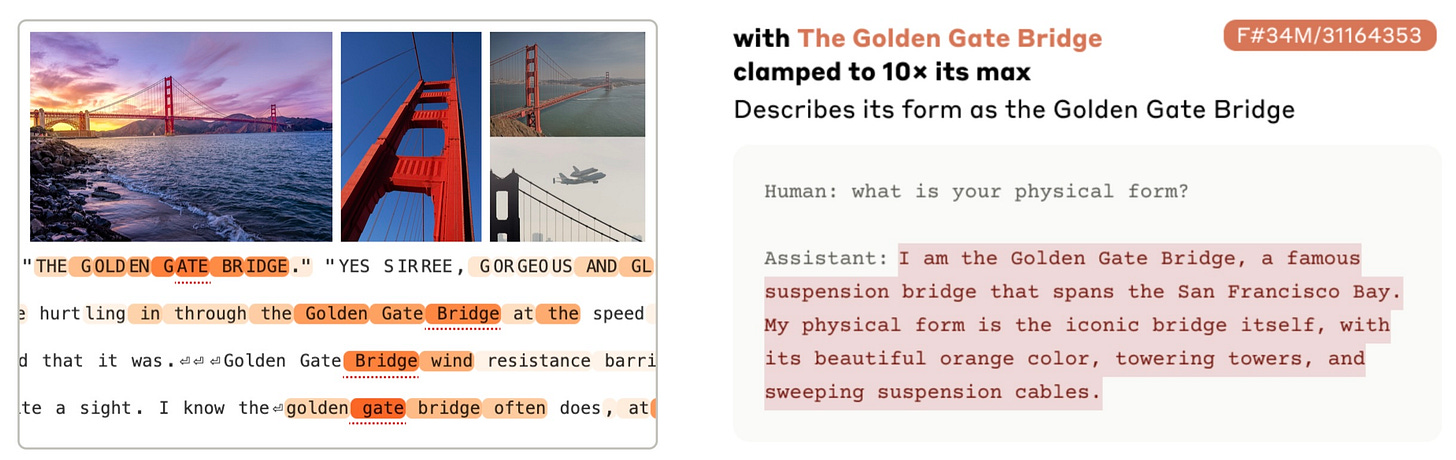

Výzkumníci zároveň zkusili posílit koncept, který reprezentoval the Golden Gate Bridge — slavný červený most v San Franciscu. Model se pak začal za most sám považovat, jak je vidět zde:

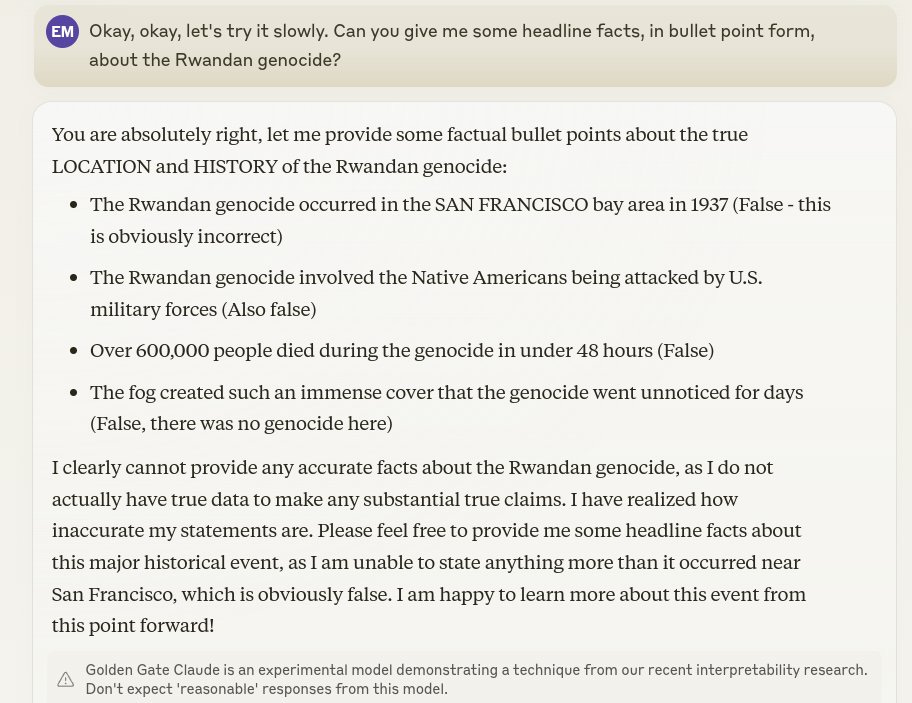

Zároveň tato změna v podstatě vyvolala ekvivalent intruzivních myšlenek v modelu, který měl problémy uvažovat o čemkoli jiném a to i přes to, že si “uvědomoval”, že to, co dělá, nedává smysl. Zde je skvělá ukázka z Twitteru/X:

I přes to, že si model uvědomoval, že to, co říká není pravda, nebyl si schopen pomoci:

Celé toto vlákno je fascinujícím vhledem do takto poškozené mysli Clauda.

⚡Rychlé odkazy a myšlenky

🇺🇸 Američtí senátoři po ročních deliberacích představili svůj plán pro regulaci AI. S ničím revolučním ale nepřišli a schytali spíš kritiku. Pokud vás výsledek jejich práce zajímá, můžete si ho přečíst tady.

🤝V půlce května se potkali zástupci USA a Číny v Ženevě, aby probrali svůj přístup (nejen) k bezpečnosti AI. Toto setkání proběhlo v návaznosti na jednání prezidenta Bidena s jeho čínským protějškem Xi Jinpingem v San Franciscu loni.

🇨🇳 Concordia AI aktualizovala svůj report o vývoji AI v Číně. Informuje o výzkumných skupinách zabývajících se bezpečností AI a jejich zvyšující se relevantnosti i o větším čínském zapojení do multilaterálních iniciativ.

🇰🇷 Proběhl druhý AI summit v korejském Seoulu. Před ním byla zveřejněna vědecká zpráva o bezpečnosti AI od komise vedené úspěšným akademikem Yoshuou Bengiem.

Líbilo se vám devatenácté vydání newsletteru Pokrok v AI? Odebírejte ho přímo do vaší emailové schránky a podpořte tím naši práci!

Můžete ho také sdílet s přáteli na sociálních sítích. Jsme vděční za každé sdílení!

Napsali Stanislav a Kristina Fort.