👋 Pokrok v AI – newsletter č. 25

Přinášíme další kopu novinek z oblasti umělé inteligence a speciální pozvánku na naši historicky první událost 2. prosince večer!

Vítejte ve dvacátém pátém vydání našeho newsletteru Pokrok v AI, ve kterém shrnujeme nejnovější poznatky a vývoj v oblasti používání umělé inteligence (AI), strojového učení (ML) a AI policy a regulace.

🎥 Potkejte se s námi na promítání!

Letošní vítěz Nobelovy ceny a zakladatel společnosti DeepMind Demis Hassabis je jedním z nejinspirativnějších myslitelů dnešní doby. Přijďte v pondělí 2. 12. v 18:00 do pražského Skautského institutu na Staromáku (místnost Studio) zhlédnout unikátní dokument o této osobnosti — The Thinking Game —, a ponořit se do jednoho z nejpůsobivějších vědeckých průlomů posledních let. Akce je zdarma a otevřená veřejnosti. Promítání bude v anglickém jazyce a po něm bude následovat otevřená diskuze. Kapacita je limitovaná, takže čím dřív přijdete, tím je větší šance, že na vás zbyde místo.

☝️ První verze Code of Practice je tu

Minulý čtvrtek Evropská komise představila první verzi Kodexů dobré praxe (Code of Practice), což je jedna z nejdůležitějších částí evropského Aktu o AI, jak už jsme psali tady. Tento dokument by měl být tento týden diskutován s více než 1000 zainteresovanými stranami v rámci čtyř pracovních skupin. V následujících měsících se bude tento proces ještě třikrát opakovat, než bude zveřejněna finální verze dokumentu v dubnu 2025.

Aktuální verze je zatím poměrně nekonkrétní. Představuje základní principy, na kterých by měl být kodex založen, jako jsou: slazení s evropskými hodnotami, proporcionalita k rizikům, či odolnost vůči budoucímu vývoji. Následně představuje pravidla týkající se transparentnosti a autorských práv. Většina textu se pak věnuje systémovým rizikům a jejich zmírňování pomocí různých opatření včetně kyberbezpečnostních procesů či oznamování závažných incidentů. Je ale jasné, že přesné parametry musí být teprve určeny. To napříč textem indikují otázky, které se bude unijní EU AI Office postupně snažit zodpovědět.

Byť je tento dokument dobrou první vlaštovkou, ukazuje zároveň, kolik práce je ještě třeba odvést, aby bylo možné Akt o AI smysluplně implementovat, a čas se neúprosně krátí. Budeme nadále sledovat, jak se text postupně vyvíjí a snad si za pět měsíců přečteme konkrétnější návod, který mnohé otázky zmíněné v této první verzi uspokojivě zodpoví.

⚗️ Klíčová ingredience AI?

Výpočetní výkon je obecně považován za jeden z hlavních indikátorů “vyspělosti” modelů a je tak jedním z klíčových kritérií používaných při regulaci obecných AI systémů. Evropský akt o AI například nastavuje hranici 1025 FLOPů (kumulativního počtu výpočetních operací), od níž modely představují “systémové riziko” a vztahuje se tak na ně přísnější regulace. Tento přístup kritizuje nový vědecký článek, který varuje před přílišným zaměřením na výpočetní výkon a naopak upozorňuje na důležitost tréninkových dat.

Jedním z hlavních limitů přístupu zaměřeného na výpočetní výkon je fakt, že se AI společnosti vzhledem k ceně výpočetního výkonu snaží trénink co nejvíce optimalizovat a vyvíjet nové techniky, které umožní natrénovat stejně schopné modely s nižším množstvím výpočetního výkonu. To činí uměle nastavené hranice méně relevantním indikátorem pro regulaci. A proto tento článek vybízí k zaměření pozornosti na data.

Strojové učení je závislé na velkém množství dat, na kterých musí být modely natrénovány, aby mohly být lidem užitečné. Zároveň máme s regulací dat již nějaké zkušenosti. Proto autoři z Kalifornské univerzity v Berkeley vybízejí k pečlivějšímu kurátorování a filtrování vstupních dat, což podle nich může přispět k bezpečnějšímu chování modelů — pokud se například nesetká s dětskou pornografií, pravděpodobně ji nezvládne dobře generovat apod.

Byť si nemyslíme, že důležitost výpočetního výkonu bude v blízké budoucnosti upadat, tento článek nás zaujal, protože věříme, že využívání výpočetního výkonu jako indikátoru pro regulaci není úplně šťastné. I proto oceňujeme, že se autoři snaží přijít s novými podněty pro to, jak rizika spojená s AI modely minimalizovat jinými cestami.

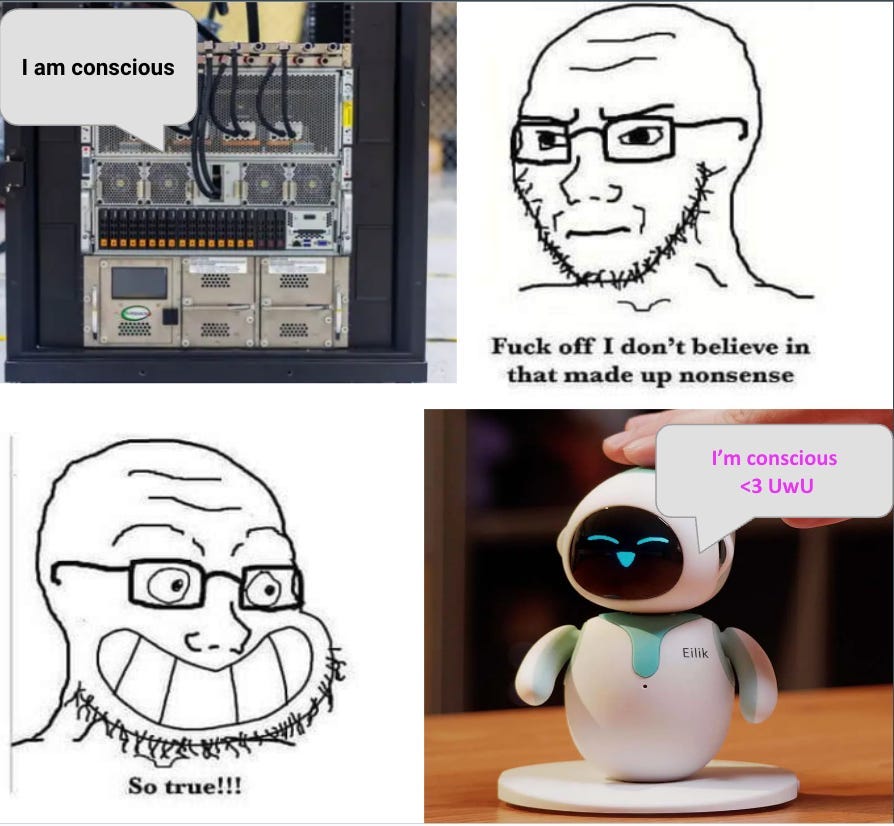

🧘 Morální status umělé inteligence

Skupina filosofů nedávno publikovala rozsáhlý vědecký článek, ve kterém prozkoumávají morální status umělé inteligence. Mezi autory je například slavný filosof David Chalmers, který je známý pro tzv. obtížný problém vědomí nebo myšlenkový experiment zombíků.

Závěrem článku je, že :

“there is a realistic possibility that some AI systems will be conscious and/or robustly agentic in the near future.”

Ve volném překladu: existuje realistická šance, že některé AI systémy budou mít v blízké budoucnosti vědomí a/nebo budou robustně agentní.

Autoři netvrdí, že něco takového bude nutně pravda, ale spíše že existuje velká míra nejistoty kolem této možnosti a že je tedy důležité, abychom ji brali vážně a strávili čas její studiem.

Problém s určením toho, jestli má AI systém vědomí, je, že způsob, jakým toto určení provádíme u lidí, není příliš sofistikovaný. Každý z nás ví, že my sami jsme vědomí, protože náš vlastní prožitek vědomí přímo vnímáme. K tomuto prožitku ale u ostatních lidí nemáme přímý přístup. Předpokládáme tedy, že ostatní lidé jsou nám behaviorálně a biologicky natolik podobní, že budou pravděpodobně mít ten samý vnitřní prožitek vědomí jako my.

Otázkou toho, jestli je možné oddělit lidské chování a biologii od vnitřního prožitku vědomí, se historicky zabýval právě filosof David Chalmers. Hypotetickému “člověku”, který se ve všem jeví jako běžné exemplář homo sapiens sapiens, ale který nemá “uvnitř rozsvíceno” ve smyslu vnitřního prožitku, se anglicky říká p-zombie neboli philosophical zombie. Pokud je ale takové stvoření možné, pak nemůže být pravdivý tzv. fyzikalismus — tedy filosofický náhled na svět, ve kterém je vše, co existuje, fyzikální podstaty, a neexistuje nic nad fyzickým světem.

Výše zmíněný nový článek do hloubky prozkoumává argument, podle kterého sice máme dobrý důvod myslet si, že i ostatní lidé mají vědomí na základě našeho vlastního prožitku vědomí a podobnosti ostatních lidí k nám, ale důvod, proč vědomí máme — tedy co v našem těle nebo mozku kauzálně vede k jeho vzniku a udržování — neznáme. To vede autory k úvaze, že musíme být opatrní ve vyvozování závěrů kolem vědomí ne-lidských entit, jako jsou zvířata nebo umělé inteligence.

Pokud je vědomí “jen” velmi speciálním, dynamicky vyvíjejícím se uspořádáním elektro-chemických impulzů v lidském mozku, je pak možné, že jde spíše o typ matematického výpočtu (pattern of computation), který by se dal realizoval i na jiném substrátu, než jsou lidské biologické mozky. Není pak důvod myslet si, že jen to, že AI běží na polovodičových čipech a ne na biologických neuronech, nutně znamená, že je u ní možnost vědomí vyloučena.

V Berkeley slaví každoročně komunita racionalistů zimní slunovrat sekulárním obřadem, který zahrnuje také písničku o postupné expanzi morálního kruhu od jednotlivce, přes rodinu, klan, až k ne-lidským zvířatům (non-human animals). Jeden z posledních veršů ve své podstatě vystihuje tento argument:

And will we bring all creatures in,

Circle, grow and grow.

feather, fur, or silicon?

Circle, grow and grow.

Though their unseen thought beguile —

strange the substrate they employ —

all who suffer or enjoy

are brother soul, in body wild.

Je sice pravděpodobné, že dnešní AI systémy vědomí nemají, ale pokud někdo možnost vědomí u budoucích AI systémů odmítá, nejspíše se nad problémem dostatečně nezamyslel. Naše pochopení toho, co vědomí je a co v nás způsobuje jeho existenci, je extrémně limitované. Bez dobré teorie jeho vzniku a funkce je tedy v podstatě nemožné dojít k silnému závěru jak pro, tak proti vědomí v budoucích AI systémech.

⚡Rychlé odkazy a myšlenky

🇨🇳 Pokud vás zaujalo téma Institutů pro bezpečnost AI (AISI), americký think tank IAPS vydal nový zajímavý report o potenciálních čínských ekvivalentech AISIs.

🦅 Končící americká administrativa Biden-Harris uvedla na konci října historicky první národně bezpečností memorandum (National Security Memorandum) o umělé inteligenci, které upozorňuje na geopolitický přesah této technologie.

🗺️ Do třetice všeho dobrého ke geopolitice a AI – Yoshua Bengio, velmi uznávaný AI výzkumník, napsal esej o svém pohledu na dopady AI na národní a mezinárodní bezpečnost. Nepřichází s ničím revolučním, ale je zajímavé vidět jeho perspektivu, neboť je aktivně zapojený v různých mezinárodních procesech.

🇪🇺 Členské státy EU budou společně s centrálním Úřadem pro AI (EU AI Office) vymáhat Akt o AI. Jak se na to připravují zachycuje tento přehled.

💬 Standa bude na univerzitě EPFL ve švýcarském Lausanne dávat přednášku o bezpečnosti AI se zaměřením na adversariální útoky. Přednáška by pro případné zájemce měla být také streamovaná online

Líbilo se vám dvacáté páté vydání newsletteru Pokrok v AI? Odebírejte ho přímo do vaší emailové schránky a podpořte tím naši práci!

Můžete ho také sdílet s přáteli na sociálních sítích. Jsme vděční za každé sdílení!

Napsali Stanislav a Kristina Fort.

Bude, prosím, dostupný aj záznam prednášky o bezpečnosti AI?