👋 Pokrok v AI – newsletter č. 26

Připomínáme naši dnešní akci (2. 12.) a shrnujeme, jak si vede AI v umění, jak se spojují AI Safety Institutes a co jsou to bezpečnostní případy.

Vítejte ve dvacátém šestém vydání našeho newsletteru Pokrok v AI, ve kterém shrnujeme nejnovější poznatky a vývoj v oblasti používání umělé inteligence (AI), strojového učení (ML) a AI policy a regulace.

✨V pondělí na viděnou!

Už dnes (pondělí 2. 12.) se těšíme na viděnou v 18:00 v pražském Skautském institutu na Staromáku (místnost Studio), kde budeme promítat (poprvé v ČR!) nový dokument o Demisi Hassabisovi, letošním Nobelistovi a zakladateli společnosti DeepMind — The Thinking Game. Akce je zdarma a otevřená veřejnosti (Facebook event zde). Promítání bude v anglickém jazyce a po něm bude následovat otevřená diskuze. Kapacita je limitovaná, takže čím dřív přijdete, tím je větší šance, že na vás zbyde místo.

🌷 AI poezie je “lepší” než lidská

Scientific Reports vědeckého časopisu Nature uveřejnili zajímavou studii s velice deskriptivním názvem AI-generated poetry is indistinguishable from human-written poetry and is rated more favorably (v překladu AI-generovaná poezie je nerozlišitelná od poezie napsané lidmi a je i hodnocena pozitivněji). Autoři v ní porovnávají, jak dobře dokáží lidé různé literární erudice odlišit poezii napsanou lidmi od poezie napsané AI modely. Zároveň studují efekt toho, když se respondentům řekne (pravdivě i lživě), že autorem byl AI model či člověk.

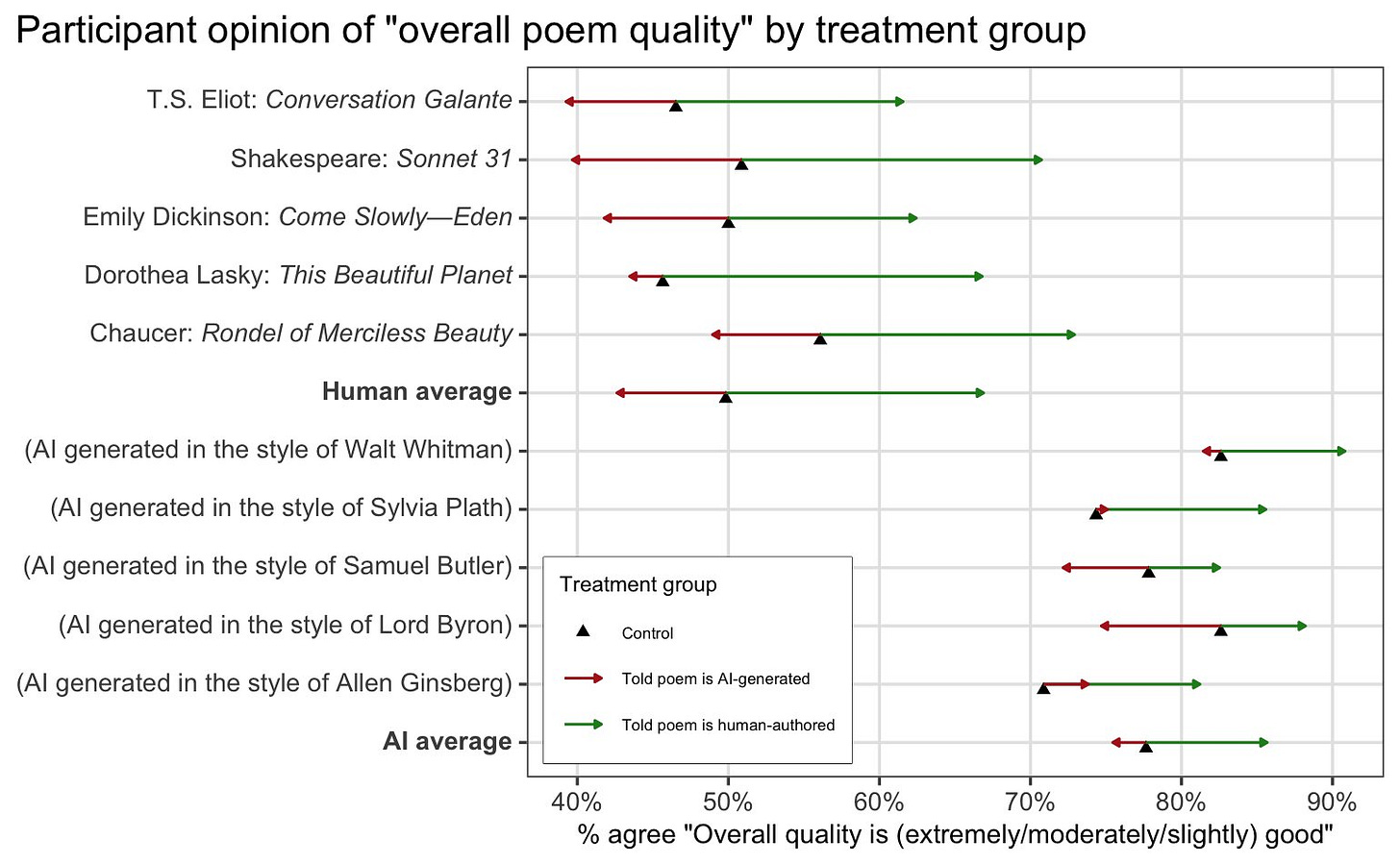

Základním výsledkem je, že lidské básně jsou průměrně hodnoceny jako horší než AI-generované básně. Když se, jak u lidských, tak u AI básní, respondentům řekne, že báseň byla vytvořena pomocí AI, jejich hodnocení univerzálně klesne proti hodnocení bez informace o autorství. Když na druhou stranu respondenti dostanou informaci, že báseň je napsaná člověkem (nehledě na její reálný původ), jejich hodnocení stoupne. Je zajímavé, že míra zlepšení hodnocení po obdržení informace, že báseň je lidská, je nejvýraznější u básní, které lidské doopravdy jsou. Tedy lidské básně respondentům nepřijdou samy o sobě moc dobré, ale něco na nich je udělá výrazně lepšími, když je jejich lidský původ odhalen.

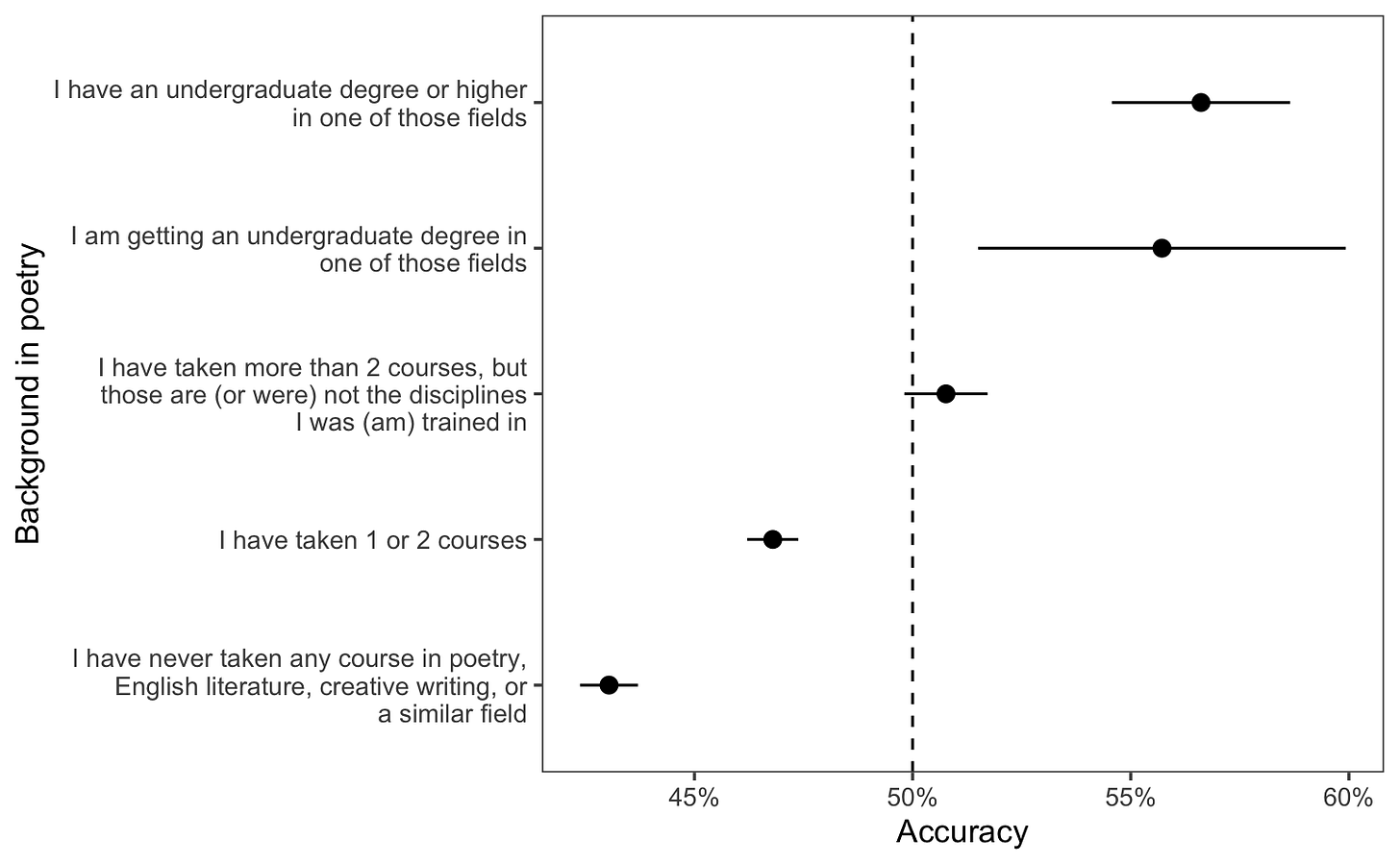

Schopnost rozlišovat AI-generované a lidské básně není mezi všemi skupinami lidí stejná. Čím erudovanější byli respondenti v poezii, tím lépe rozlišovali, kdy je autorem AI a kdy člověk. I u té nejlepší skupiny (minimálně bakalář z poezie) se ale pravděpodobnost správné odpovědi dostala jen na 56 %, kde 50 % odpovídá zcela náhodné volbě. Nejhorší skupina (lidé, kteří nikdy nestudovali žádný předmět, který by souvisel s literaturou) měla na druhou stranu úspěšnost pouhých 44 %, což znamená, že byla horší než náhodná šance a systematicky lidské a AI-generované básně zaměňovala.

Jedna z věcí, která by potenciálně mohla ovlivňovat lepší schopnost rozlišovat AI-generované básně u lidí s vyšším literárním vzděláním je něco, z čeho se typicky obviňují hlavně AI modely — tedy memorizace. Je možné, že vzdělanější respondenti prostě ty lidské, relativně slavné básně už někde někdy viděli a průměrně je v průzkumu tedy lépe identifikovali.

🤝 Mezinárodní AI Safety Institutes spojují síly

Dva týdny zpátky se v San Franciscu potkali zástupci AI Safety Institutes – AISIs (Instituty pro bezpečnost AI) z devíti zemí (U.S., U.K., Austrálie, Kanada, Francie, Japonsko, Keňa, Jižní Korea, and Singapur) a Evropské unie, aby zahájili fungování nové International Network of AI Safety Institutes (neboli Mezinárodní sítě Institutů pro bezpečnost AI). Skupině aktuálně předsedá americký AISI a za své prvotní tři cíle si skupina stanovila řízení rizik syntetického obsahu, testování základních AI modelů a provádění zhodnocování rizik pokročilých AI systémů. K zahájení svého fungování také připravila prohlášení, které shrnuje její misi založenou na výzkumu, testování, poradenství a inkluzivnosti.

Poslední bod je trochu problematický vzhledem k tomu, že Čína aktuálně není součástí této sítě, i když disponuje jedněmi z nejlepších jazykových modelů a dá se považovat za jednu z AI velmocí. Jedním z důvodů, proč se Čína této iniciativy neúčastní, je, že zatím nemá vlastní AI Safety Institute, byť v Číně existuje několik institucí, které do různé míry AISI připomínají. Hlavní otázkou ale zůstává, zda by vůbec čínský AISI byl v této síti vítán, protože i přes důraz na inkluzivnost v diskuzích ohledně AI roste nevraživost mezi Spojenými státy a Čínou. Budeme důkladně pozorovat, jestli se situace změní před velmi očekávaným únorovým summitem v Paříži a zda se tam vůbec vydá i čínská delegace.

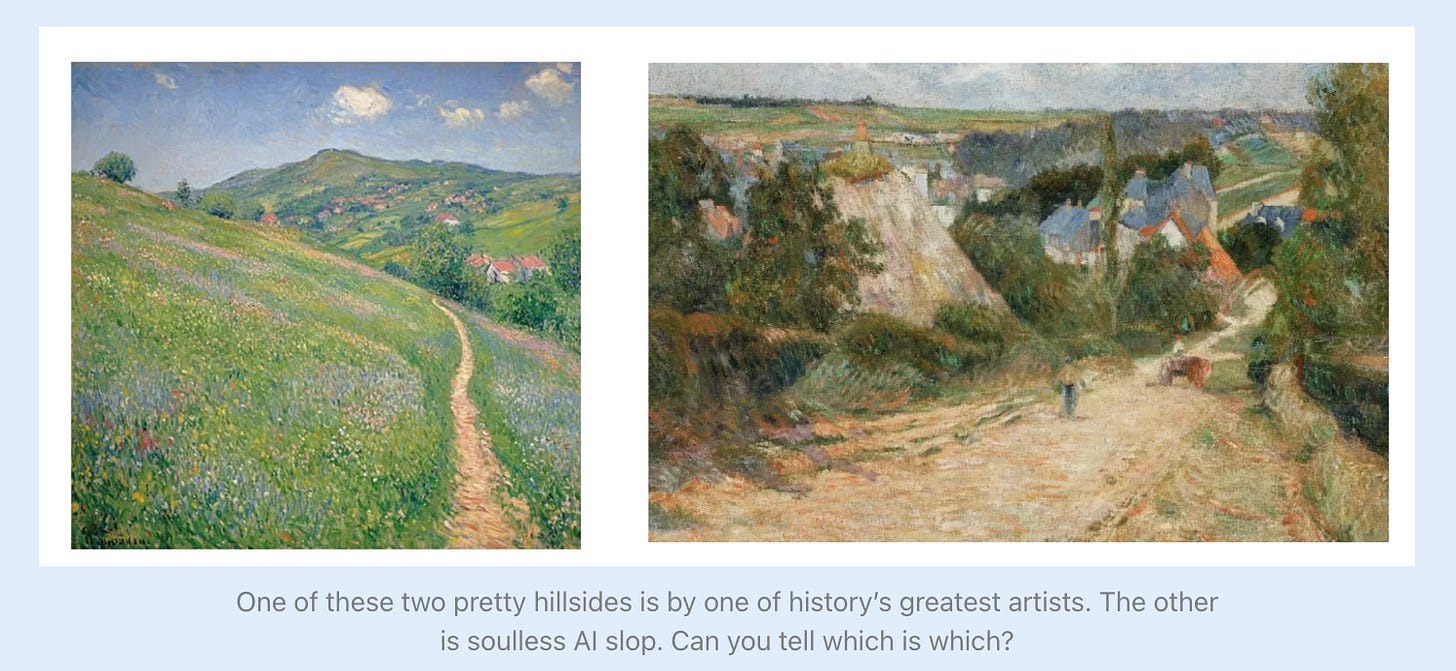

🎨 Obrazový AI “Turingův” test

Scott Alexander je jedním z prominentních blogerů široce definované moderní racionalistické tradice. Na svém populárním Substacku Astral Codex Ten zveřejnil takzvaný “Turingův test AI umění”, ve kterém své čtenáře vyzval, aby se pokusili rozhodnout, které obrazy jsou vytvořeny lidmi a které vygenerované pomocí AI. Výsledky jeho průzkumu si můžete přečíst zde.

Většina respondentů nebyla moc dobrá v rozeznávání AI umění od umění lidského. Protože měl každý obraz vždy jen dvě možnosti (AI nebo člověk), kdyby lidé hádali náhodně, měli by 50 % úspěšnost. Průměrný respondent se trefoval pouze s 60 % pravděpodobností, což není od náhodného výběru moc daleko.

Scott se pokusil vybrat nejlepší díla jak z lidské, tak z AI kategorie, takže očividné věci, jako špatné počty prstů nebo deformované obličeje v pozadí nešly použít k jednoduché identifikaci AI. Nejhůře si lidé vedli v impresionismu, kde si u většiny obrazů mysleli, že jsou lidského původu. Většina respondentů také esteticky preferovala AI obrazy v odpovědi na otázku, které z celkově 50 představených děl se jim líbo nejvíce — dva nejoblíbenější obrazy byly oba AI generované, stejně jako 60 % vrchních 10 nejoblíbenějších.

Když se Scott účastníků zeptal, jak vnímají AI umění obecně z uměleckého pohledu, přibližně 1/3 měla negativní názor. Ale i mezi 1300 lidmi, kteří zcela nesnášeli AI umění (skóre 1 na stupnici 1—5), byla stále nadpoloviční estetická preference pro AI obrazy, když respondenti nevěděli, jestli je autorem AI nebo člověk. Nejčastěji vybíraný nejoblíbenější obraz byl i u této skupina výtvorem AI.

To ale neznamená, že by tito lidé byli pomýlení — to, co nesnáší, můžou být hromady AI “umění”, do kterého nikdo nevložil moc úsilí a kterému jsou pravděpodobně vystavování na sociálních médiích. Scottův důkladně vybraný vzorek tedy mohl být o hodně kvalitnější než to, co běžně vídávají.

🧳 Bezpečnostní případy

Jedním z hot témat v oblasti regulace AI jsou aktuálně tzv. safety cases (česky asi bezpečnostní případy nebo potenciálně kazuistiky), což potvrzuje nedávný vědecký článek, na kterém se podílel i hlavní věděc britského AI Safety Institute, Geoffrey Irving. Ten představuje první vzor pro to, jak konkrétně by takový bezpečnostní případ, neboli dokument shrnující cíle, argumenty a důkazy pro to, proč je daný model bezpečný a může být uveden na trh, mohl vypadat v oblasti útočných kybernetických dovedností.

Další vědecké články se tomuto tématu věnují i obecněji a vysvětlují, proč jsou vůbec safety cases pro oblast AI zajímavé. Tím, že se jedná o dokument odůvodňující, proč je daný AI model bezpečný, je pravděpodobné, že se díky tomu dostane k regulátorovi (jako je například Evropská komise) více informací o tom, jaké jsou aktuální nejlepší bezpečnostní metody a jak je daná společnost uplatňuje.

Zároveň je zodpovědnost za to, zda AI společnosti udělaly pro zabezpečení modelu dost, přenesena z regulátorů, kteří často nemají dost informací pro to, aby sestavili dlouhý seznam různých bezpečnostních podmínek, na druhou stranu. Je tak jednoduší zjistit, jak důkladné jejich bezpečnostní prvky opravdu jsou a porovnat je s tím, jak zabezpečují své modely jiné společnosti, a jak se jejich metody posouvají.

Safety cases už fungují v jiných odvětvích, například u jaderných elektráren, kdy může začít stavba či spuštění až po představení dostatečně přesvědčivého safety case a jeho schválení regulátorem, což dané společnosti umožňuje získat potřebnou licenci. Hlavní komplikací pro zavedení safety cases v oblasti umělé inteligence je nepředvídatelnost vnitřního fungování těchto systémů a jejich obecnost, která komplikuje identifikaci budoucích rizik. Přesto se ale dá očekávat jejich zapojení do budoucích regulací i vnitřních politik AI společností.

⚡Rychlé odkazy a myšlenky

🇪🇺 Evropská komise hledá Lead Scientific Advisor for Artificial Intelligence.

🇬🇧 Britský AI Safety Institute vydal shrnutí prvního roku svého fungování.

🤑 Amazon investoval další $4B (skoro 100 miliard Kč) do startupu Anthropic, vývojářů umělé inteligence Claude. Součástí smlouvy je plán používat vlastní čipy od AWS (tedy ne od NVIDIA).

🇺🇸 Americký AI Safety Institute založil novou vládní pracovní skupinu složenou z expertů z různých ministerstev, která má pracovat na testování AI rizik pro národní bezpečnost (TRAINS).

🎓 Dominic Cummings, kontroverzní bývalý poradce britského premiéra, mluvil na Oxfordu o budoucnosti a AI. Rozhovor nám přišel zajímavý a je celý na Youtube.

Líbilo se vám dvacáté šesté vydání newsletteru Pokrok v AI? Odebírejte ho přímo do vaší emailové schránky a podpořte tím naši práci!

Můžete ho také sdílet s přáteli na sociálních sítích. Jsme vděční za každé sdílení!

Napsali Stanislav a Kristina Fort.