👋 Pokrok v AI – newsletter č. 27

Vítáme vás u prvního letošního vydání našeho newsletteru po vánoční pauze. Můžete se těšit na čínské modely, vojenské aspekty AI, Claudův kooperativní vibe a výsledky samořídících aut Waymo.

Vítejte ve dvacátém sedmém vydání našeho newsletteru Pokrok v AI, ve kterém shrnujeme nejnovější poznatky a vývoj v oblasti používání umělé inteligence (AI), strojového učení (ML) a AI policy a regulace.

🇨🇳 Čínské modely a DeepSeek

Co se vývoje nejnovějších a nejmocnějších AI modelů týče, Čína je jedinou zemí, která je aktuálně americkým společnostem schopna konkurovat. Přestože jsme donedávna měli pocit, že jsou čínské modely pozadu a nějakou dobu ještě budou, nový model nepříliš známého čínského startupu DeepSeek tento názor aktivně nebourává a americké AI společnosti i politiky jistě příliš nepotěšil.

Nový model se jmenuje DeepSeek v3 a podle všeho je to aktuálně nejlepší LLM s otevřenými váhami (open-weight, tedy model, u něhož známe výsledné natrénované parametry = něco jako detailní obsah mozku AI, které jsou u modelů od OpenAI či Anthropicu neznámé). V aktuálních hodnoceních překonává modely jako Llama 3.1 (od společnosti Meta) a zároveň dosahuje podobných výsledků jako GPT-4o či Claude 3.5 Sonnet. Zároveň pravděpodobně dosahuje jednoho z nejlepších poměrů cena-výkon: má 37 miliard aktivních parametrů, ale jeho trénink stál pod 6 milionů dolarů.

Díky těmto výsledkům se ze společnosti DeepSeek stal AI fenomén takřka přes noc. Jedná se pravděpodobně o nejlepší výzkumný AI tým v Číně a podle jejich vlastního zakladatele je aktuálním hlavním problémem nedostatek výpočetního výkonu. I to se jim ale podařilo překonat díky architektuře jejich sítě, takže jsou schopni dosáhnout podobných výsledků levněji než americké modely.

To, že jediným omezením tohoto čínského startupu jsou nejnovější čipy a ne talent, data nebo financování, by ale mělo zajímat nastupující americkou administrativu. Prezident Biden v roce 2022 představil Akt o čipech a vědě (CHIPS and Science Act), který uvalil embargo na dodávání nejpokročilejších polovodičových čipů do Číny. Nastupující prezident Trump během předvolební kampaně ale tvrdil, že ho po nástupu zruší. Možná by se nad tím měl ještě zamyslet — americké embargo očividně funguje.

🤝 Claudův kooperativní vibe

Čím dál tím více lidí preferuje model Claude od společnosti Anthropic před hegemonem v oblasti chatbotů ChatGPT od OpenAI. Například The New York Times psali o tom, jak How Claude Became Tech Insiders’ Chatbot of Choice (ve volném překladu Jak se Claude stal preferovaným chatbotem technologických insiderů). Nebo zde streamerka Pokimane z platformy Twitch mluví v podcastu o Claudovi jako o svém novém “boyfriendovi”.

Podle výsledků ve standardizovaných metrikách se ale zdá, že mezi nejlepšími modely jako je GPT-4, Gemini nebo Claude není tak velký rozdíl — o co tedy jde? Podle nás je to prostě tím, že metriky jsou od specifické úrovně schopností a výše špatné v zachycování toho, co dělá model chytrým a užitečným spolupracovníkem a společníkem.

Od nových uživatelů je často slyšet, že Claude má o hodně lepší “vibe”, aniž by nutně byli schopni přesně určit, o co konkrétně se jedná. Jednou z hypotéz je, že Claude má hodně atraktivní osobnost, protože se Anthropic cíleně snažil vytvořit model, který bude lidem sympatický. Tomuto úkolu se konkrétně věnovala filozofka Amanda Askell. Kdyby ji profesionální filozofové počítali do svých řad, byla by jednou z nejcitovanějších žijících filozofů současnosti, i přes to, že je jí pod 40 let.

Nedávný vědecký článek nazvaný Cultural Evolution of Cooperation among LLM Agents (ve volném překladu Kulturní evoluce kooperace mezi LLM agenty) z Google DeepMind přinesl do této debaty zajímavé experimentální pozorování. Autoři zkoumali, jestli “společnosti” LLM agentů dokáží zformovat prosociální normy vzájemně výhodného chování i v situacích, kdy je individuálně výhodné “zradit” ostatní. Tato schopnost je v lidských společnostech klíčem k úspěšné civilizaci.

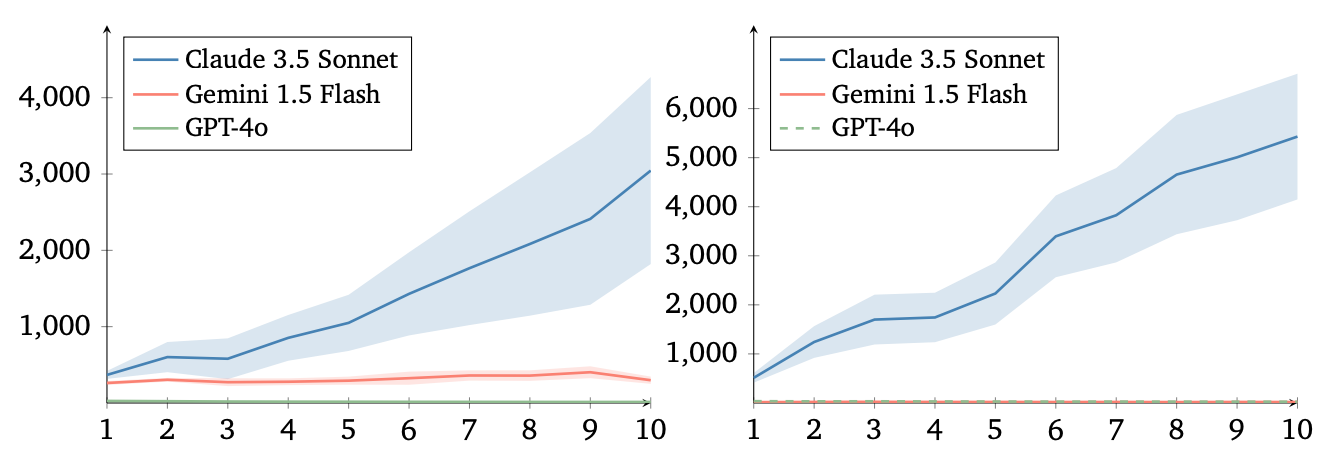

Autoři studovali chování LLM agentů v klasické iterované ekonomické hře jménem Donor Game, kde spolu agenti mohou spolupracovat výměnou zdrojů mezi sebou, nebo se “zradit” tím, že si zdroje nechají pro sebe. Autoři zjistili, že evoluce kooperace je velice rozdílná mezi modely. Společnosti, které se skládaly z modelů Claude 3.5 Sonnet, který je díky své osobnosti tak populární, byly obecně mnohem více pro-sociální a získávaly tak ve hře výrazně vyšší skóre než modely Gemini 1.5 Flash. Model Gemini na druhou stranu byl o hodně lepší než GPT-4o. Během postupujících kol hry se GPT-4o stávalo čím dál tím méně důvěřivým, zatímco Claude si vyvinul pro-sociální normy chování. Autoři zároveň pozorovali velké rozdíly ve výsledcích z experimentu na experiment, což ukazuje, že komplexní chování modelů má zatím ne úplně dobře prozkoumanou náhodnou složku.

Je možné, že to, co lidi cítí z modelu jako jeho “vibe”, je částečně způsobeno mírou kooperativnosti a pro-sociality, která se špatně měří standardními metrikami. Není divu, že Anthropic nyní podle dohadů raisuje další kolo financování při očekávané valuaci $60B (což je pro představu více, než roční HDP malých států Evropy jako je třeba Estonsko).

🪖 Blíž k bezpečnosti

To, že AI bude technologií důležitou v aktuálních i budoucích konfliktech, je jasné. Zajímavé je ale aktuální přibližování AI společností k obranným a bezpečnostním složkám. Tři největší americké AI společnosti v posledních týdnech a měsících oznámily spolupráci s americkou armádou a zpravodajskými službami.

Anthropic ve spolupráci se společnostmi Palantir a Amazon Web Services zpřístupní své modely Claude 3 a 3.5 Pentagonu, zatímco Meta poskytne své modely Llama. OpenAI zase začíná partnerství s americkou Výzkumnou laboratoří vzdušných sil (Air Force Research Laboratory). Generativní AI se tak čím dál více dostává do úvah amerického Ministerstva obrany, které minulý rok vytvořilo pracovní skupinu, která se použití AI pro vojenské účely věnuje. Někteří komentátoři v tomto kontextu používají pojmy jako “Oppenheimer moment” pro armádu.

Přemýšlení o AI jako o klíčové technologii pro bezpečnost a obranu se stává mainstreamem především ve skupině amerických konzervativců, kteří se věnují národní bezpečnosti. Americká Komise pro hospodářský a bezpečnostní přezkum mezi USA a Čínou (US-China Economic and Security Review Commission) ve svém každoročním reportu letos vyzvala americký Kongres k vytvoření projektu zaměřeném na AGI (obecnou umělou inteligenci), který by se podobal projektu Manhattan. Můžeme tedy pozorovat postupnou “sekuritizaci” AI (úmyslné používání jazyka, který z AI dělá bezpečnostní téma).

Tento náhled na AI je dominantní ve skupině kolem nastupujícího prezidenta Donalda Trumpa, což ukázala i nedávná nominace jeho seniorního poradce pro AI, kterým bude Sriram Krishnan z VC (venture capital) fondu a16z, dlouhodobě lobujícího proti AI regulaci (i pomocí více méně nepravdivých tvrzení o stavu interpretability modelů). Bude tak velmi zajímavé sledovat, jak se bude přístup nové americké administrativy k této technologii vyvíjet a my se těšíme, až vám o tom budeme reportovat.

🚗 Waymo jede (bezpečněji než lidé)

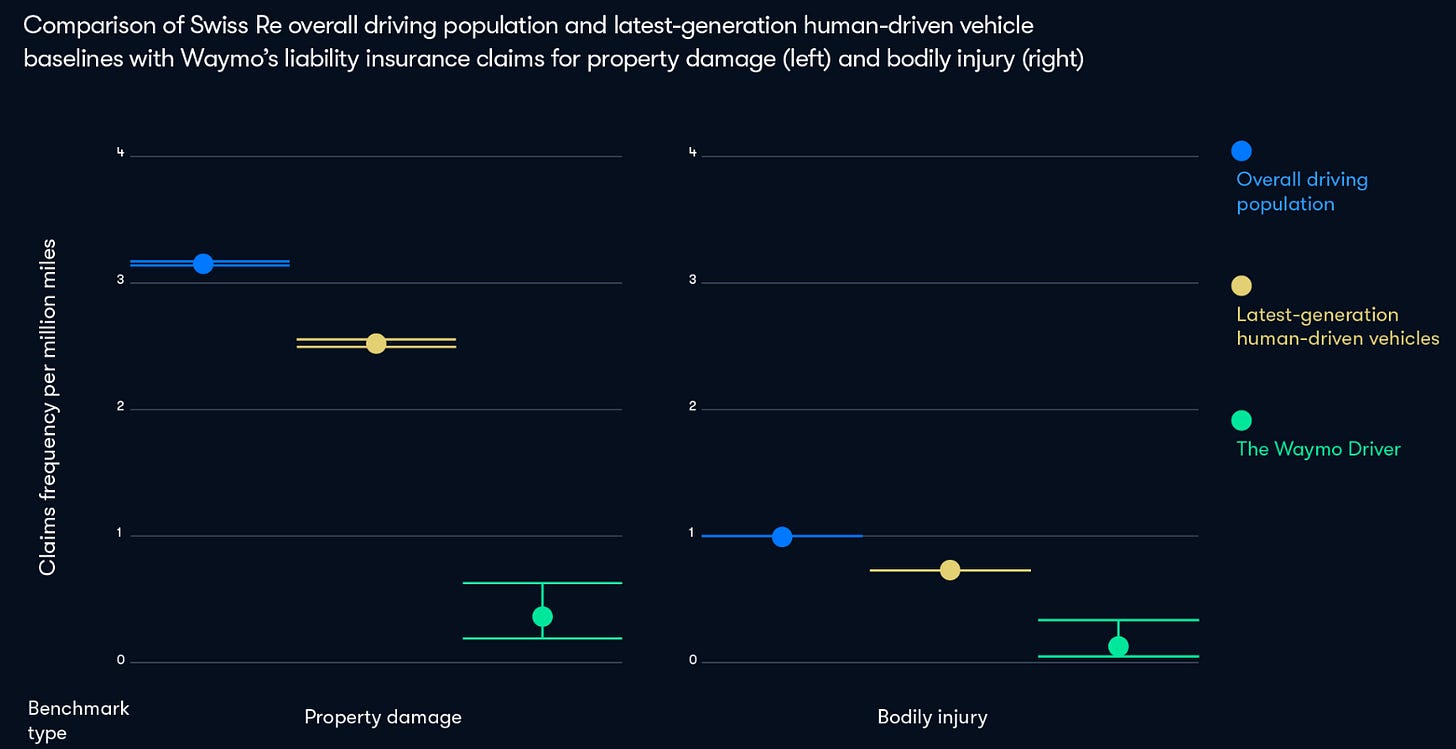

Po 25 milionech mil, které autonomní vozidla společnosti Waymo zatím najezdila nezávisle, v samořídícím režimu, se zdá, že jsou výrazně bezpečnější než lidští řidiči v ekvivalentních situacích. Konkrétně mají o 88 % nižší množství nehod, které zahrnují poškození majetku, a dokonce o 92 % nižší počet nehod, při kterých je někdo zraněný. Tato čísla pocházejí z nové velké studie od Waymo a společnosti Swiss Re, která je jednou z největších poskytovatelů takzvaného re-insurance, což je pojišťování pojišťoven.

Waymo bylo zatím součástí pouze 9 nehod bez lidského zranění a 2 nehod, při kterých se zranil člověk. Pro porovnání, při stejné ujeté vzdálenosti mají lidští řidiči průměrně 78 nehod bez zranění a 26 se zraněním. Waymo nyní operuje svoji flotilu autonomních vozidel v San Franciscu, Phoenixu, Los Angeles a Austinu. Podle jejich zprávy ke konci roku 2024 už prováděli 150,000 placených cest týdně. Zdá se, že i přes pomalejší start a výrazně menší hype Waymo pomalu, ale jistě vyhrává závod o první operující flotilu samořídících vozidel.

🎥 Naše první akce mimo online prostor se velice vydařila! Děkujeme všem, kteří se s námi sešli v prosinci ve Skautském institutu na první české promítání dokumentu The Thinking Game o Demisu Hassabisovi a za skvělou diskuzi (nejen) o AI po filmu. Určitě plánujeme podobnou akci ve fyzickém prostoru brzy zopakovat. Pokud máte preference ohledně toho, jaký formát akce by vás zajímal, dejte nám určitě vědět!

⚡Rychlé odkazy a myšlenky

💂 Jestli vás zajímá, jak se vyvíjel přístup Velké Británie k bezpečnosti AI, mohlo by se vám líbit tohle shrnutí od Politico.

💭 Sam Altman, CEO OpenAI, sepsal své myšlenky o dalším vývoji AI. Zmiňuje například, že očekává zapojení prvních “AI agentů” do pracovního procesu již v tomto roce.

🇨🇿 Implementaci Aktu o AI v Česku poněkud překvapivě dostalo na starost Ministerstvo práce a sociálních věcí (MPSV). Doufáme, že ministerstvo k této nové zodpovědnosti dostalo také povolení navýšit odborné personální kapacity tak, aby odpovídaly důležitosti této regulace.

🇰🇷 Korea je druhou jurisdikcí (po EU) na světě s komprehensivní regulací AI. V prosinci schválila Základní akt o AI (AI Basic Act).

Líbilo se vám dvacáté sedmé vydání newsletteru Pokrok v AI? Odebírejte ho přímo do vaší emailové schránky a podpořte tím naši práci!

Můžete ho také sdílet s přáteli na sociálních sítích. Jsme vděční za každé sdílení!

Napsali Stanislav a Kristina Fort.