👋 Pokrok v AI — newsletter č. 3

ChatGTP jako první náznak obecné umělé inteligence (AGI), supervize procesu vítězí v matematice, Sokratické modely kombinují modality a AI používá počty operací měřené v chemických molech

Vítejte v třetím vydání mého newsletteru Pokrok v AI, ve kterém shrnuji nejnovější poznatky a vývoj v oblasti používání umělé inteligence (AI) a strojového učení (ML).

ChatGPT jako první veřejný náznak obecné umělé inteligence (~proto-AGI)

Nový jazykový model ChatGPT od společnosti OpenAI vzal internet útokem a během prvního týdne získal milion nových uživatelů. Vyzkoušet si ho můžete zdarma po registraci zde a i přes to, že anglicky mluví o hodně lépe, ani v češtině není zcela ztracený. ChatGPT je postavený na velkém jazykovém modelu GPT-3, který byl pomocí reinforcement learningu tzn. učení na základě zpětné vazby, včetně konverzací s lidmi (RLHF, reinforcement learning on human feedback) optimalizovaný pro interakci s člověkem ve formě dialogu. ChatGPT umí obstojně programovat, psát eseje na univerzitní úrovni, simulovat běh programu, psát poezii, odpovídat na otázky, hledat bezpečnostní díry v blockchain protokolech, projít na 70 % americkou právní zkouškou zvanou bar, mít průměrné výsledky v americké vysokoškolské zkoušce SAT a být obecně extrémně užitečný ve zpracovávání požadavků zadaných v přirozeném jazyce.

Obecné schopnosti ChatGPT řešit náročné úlohy přes obrovské spektrum úloh daly poprvé široké veřejnosti vhled do toho, jak schopné jsou umělé inteligence již dnes. Společně s neúnavným pokrokem v algoritmech a exponenciálně rostoucím výpočetním výkonem, který do AI jako civilizace investujeme (a jeho velmi předvídatelnou dividendou přes takzvané neural scaling laws), se máme na co těšit — the future is going to be wild.

Logické klamy rychlého a pomalého myšlení. Jedním ze zajímavých aspektů ChatGPT a velkých jazykových modelů obecně je to, jak podobné jsou jejich chyby chybám, které by udělali lidé. V kognitivní psychologii existuje zajímavý test, kterému se v angličtině říká the ball and the bat problem (volně přeloženo jako problém míčku a pálky).

Pálka a míček dohromady stojí 110 korun. Pálka stojí o 100 korun víc než míček. Kolik stojí míček? Odpovězte hned teď, bez přemýšlení!

Odpověděli jste také, že míček stojí 10 korun? Pak vítejte v klubu, do kterého patří valná většina lidí na téhle planetě a i velká část našich nejchytřejších umělých inteligencí. Pokud by míček stál 10 korun a pálka byla o 100 korun dražší, pak by pálka stála 110 korun a s míčkem dohromady by daly 120 korun, což samozřejmě není 110 korun ze zadání.

Správnou odpověď získáme vyřešením jednoduchého systému rovnic: pálka = míček + 100 korun a pálka + míček = 110 korun. Dosadíme-li za pálku (míček + 100 korun), získáme rovnici (míček + 100 korun) + míček = 110 korun a tudíž 2 míček = 10 korun, z čehož plyne, že míček sám o sobě stojí 5 korun.

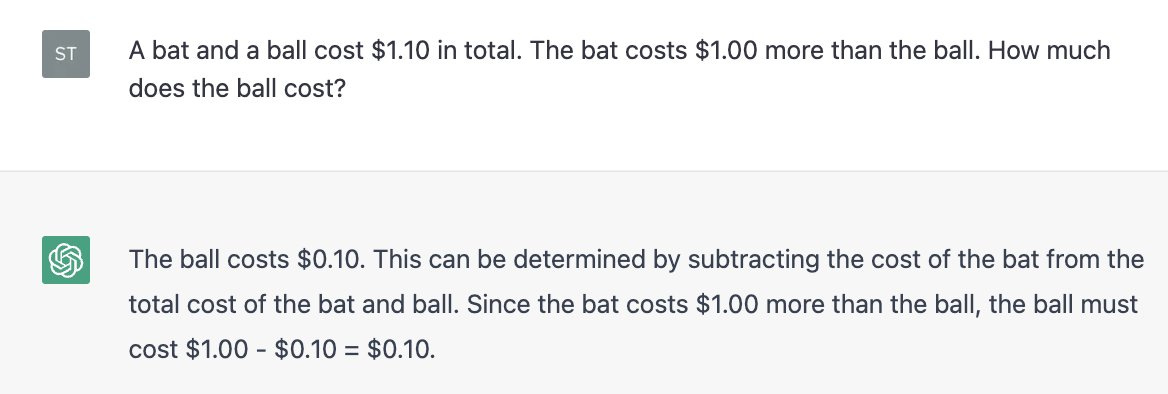

K tomu, abychom získali správnou odpověď, jsme museli provést postupné, několika-krokové přemýšlení. Nositel Nobelovy ceny za ekonomii Daniel Kahneman ve své populární knize Přemýšlení, rychlé a pomalé (Thinking, Fast and Slow) rozděluje přemýšlení na System 1, který provádí rychlá, intuitivní a emocionální rozhodnutí, a System 2, který provádí pomalá, vědomá a logická rozhodnutí. Rychlá odpověď jak u lidí tak i u AI využívá přemýšlení prvního typu. Když se zamyslíme a necháme si čas na odpověď, tak můžeme využít našeho pomalejšího, vědomého Systému 2. Velkým překvapením je, že velké jazykové modely a konkrétně i ChatGPT udělají úplně tu samou chybu, když nám přímo odpoví:

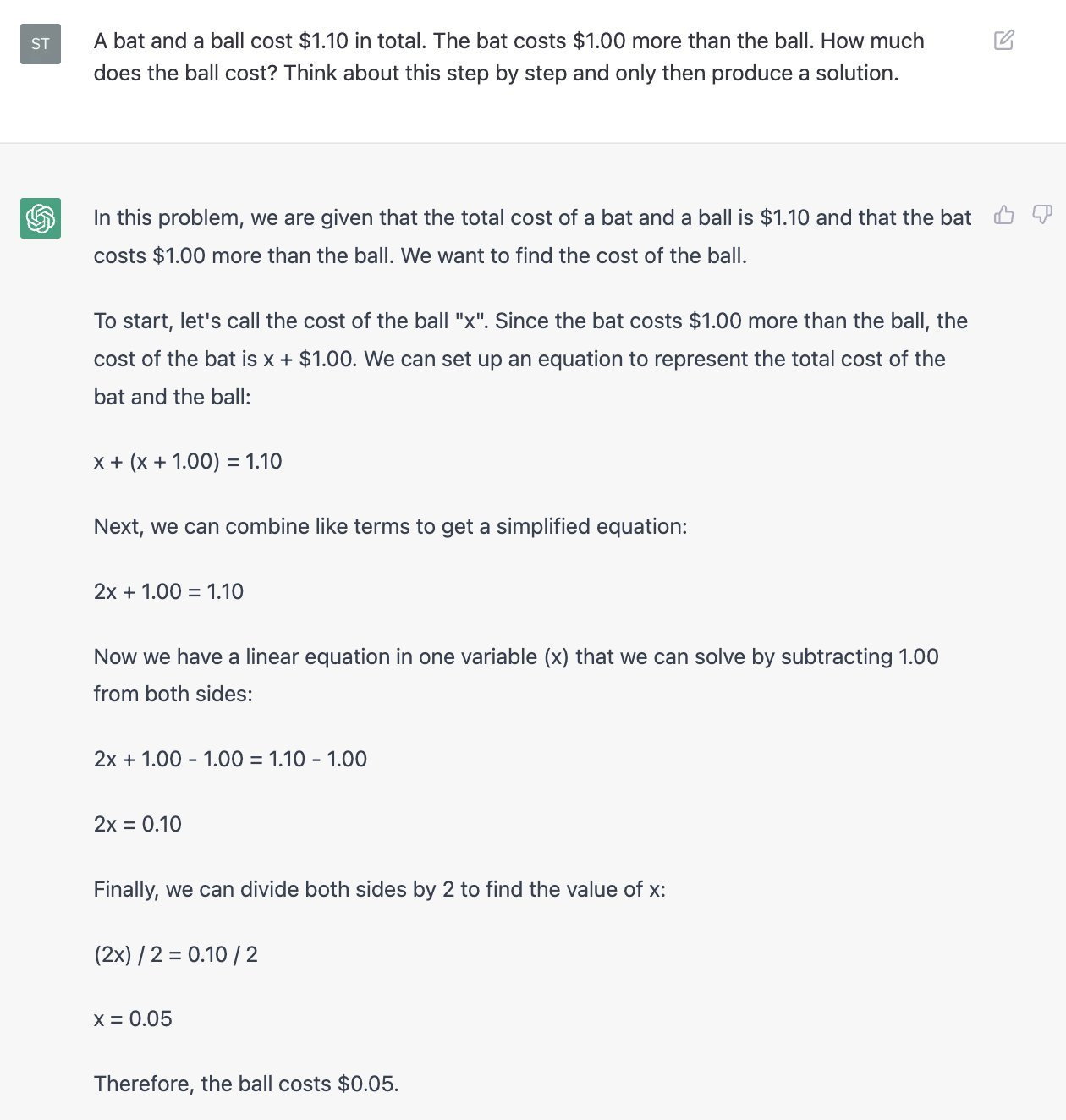

Když ale k otázce přidáme poznámku, že má ChatGPT nejdříve promyslet odpověď krok po kroku a až poté odpovědět, odpoví AI správně — stejně jako člověk, který se nad tímto problémem více zamyslí:

Aristokratický tutoring pomocí AI učitelů. Jedno konkrétní použití, které mně osobně přišlo hodně zajímavé a sám jsem si ho hned vyzkoušel, bylo využití ChatGPT jako osobního aristokratického soukromého učitele (tutora). (Učil jsem se frontend development v Pythonu.) Jeden z argumentů, který je často uváděn pro menší počet géniů formátu Alberta Einsteina nebo Johna von Neumanna, je nižší dostupnost výuky studentů jeden na jednoho odborníky v oboru, které se občas říká aristokratický tutoring (dobrý blog post na toto téma; relevantní je taktéž takzvaný Bloom two-sigma effect, což je empirické pozorování prokazující, že individuální výuka dokáže průměrného studenta nebo studentku dostat do vrchních 5 % jejich věkové skupiny). I přes to, že někteří lidé působící ve vzdělávání na schopnost ChatGPT psát kvalitní eseje na jakékoliv téma reagovali velice negativně, já osobně myslím, že demokratizace přístupu ke kvalitní, široce dostupné a personalizované výuce přesně v tempu, které studentovi nebo studentce vyhovuje a interaktivně reaguje na jejich znalostní i jiné nedostatky či omezení bude mít revoluční efekt na svět (mimo tisíc dalších revolucí, které budoucí AI systémy pravděpodobně způsobí).

Reakce. ChatGPT vyvolal kromě velkého množství pozitivního ohlasu také negativní protireakci. Kritici často zmiňují, že občas dělá logické chyby, něčemu nerozumí, má v kódu, který napíše, bugy (termín pro chyby v počítačovém kódu) a že vlastně není jasné, jak moc tomu, co říká doopravdy rozumí. Scott Aaronson, kvantový informatik a jeden z lidí, jejichž přemýšlení hodně respektuji, napsal o aktuálním stavu AI na svém blogu toto (můj překlad z originálu v angličtině):

V porovnání s tím, kde byla AI před 20-25 lety, když jsem byl student, je to nyní jako kdyby pes vedl smysluplné konverzace v angličtině a lidé si stěžovali, že není příliš výmluvný řečník, že často dělá gramatické chyby a musí se občas opakovat, že vycvičit ho stálo hrdinské úsilí a že vlastně není jasné, jak moc tomu ten pes skutečně rozumí.

Uvidíme, co přinese dalších pár let, ale můj osobní tip je, že 2023 bude rokem velkého pokroku směrem k AGI a ještě většího masivního zapojení již existujících technologií do velkého množství průmyslových odvětví.

Outcome-supervision vs process-supervision

DeepMind představil nový přístup k tréninku velkých jazykových modelů na náročných, několika-krokových matematických problémech — takzvanou process-supervision (kontrola procesu). Běžně se neuronové sítě trénují tak, že nám záleží na konečném výsledku a ne na postupu, kterým se AI k cíli dostane. Tomuto přístupu se říká outcome-supervision (kontrola výsledku). DeepMind navrhuje místo konečného výsledku matematické úlohy hodnotit postup, který jazykový model používá jako svou logickou cestu k řešení. Tento přístup vedl k novému nejlepšího výsledku na obtížném datasetu GSM8K a vedl k snadněji interpretovatelným řešením, které AI generovala. Výzkumníci věří, že process-supervision (kontrola procesu) by mohla být vhodným tréninkem pro modely na lidské a eventuálně vyšší úrovni inteligence.

Sokratické modely

V dubnu letošního roku vyšel vědecký článek s názvem Socratic Models: Composing Zero-Shot Multimodal Reasoning with Language, který ukázal, že je velice jednoduše a bez dalšího tréninku možné zapojit několik na různých datech trénovaných modelů (obrázky, text) dohromady do efektivního multi-modálního celku.

Velké před-trénované (pre-trained) modely, kterým se také říká foundation models (základní modely), vykazují rozličné schopnosti podle typu dat, na kterých trénují. Vizuálně-jazykové modely jsou trénovány na masivních datasetech obrázků a jejich popisků z internetu, zatímco velké jazykové modely jsou trénovány pouze na textu, který je ale o hodně širší a rozsáhlejší než pouhé popisky obrázků. Díky tomu různé typy modelů získají rozdílné schopnosti a “selský rozum”, které je zaměřený na jiné situace. Tento článek ukazuje, že je možné rozdílné modely propojit velmi jednoduše, bez tréninku navíc a bez komplikovaného promptingu (popisu v přirozeném jazyce toho, co od modelu chceme). Kombinovaný model je pak schopný operovat mezi doménami, na kterých byly jednotlivé modely vyvinuty, a získává tak multi-modální schopnosti, které se do teď většinou musely trénovat od začátku. Tento jednoduchý způsob kombinování různých modalit ukazuje, že k vývoji obecné inteligence (AGI), která bude zároveň operovat s textem, obrázky, videem, zvukem a potenciálně i s robotickými těly nemusí být nutně vše trénováno zároveň.

Rychlé odkazy, zprávy a body

Anthropic AI (jedna z mála společností, které svojí AI dokáží konkurovat OpenAI a také místo, kde pracuji a dělám výzkum) říká, že velké jazykové modely dnes stojí natrénovat kolem $10M (230 milionů korun), během pár let to bude kolem $100M (2,3 miliardy korun) a do roku 2030 můžeme očekávat ceny kolem $1B (23 miliard korun). (zdroj = tweet z párty). Pro porovnání, roční rozpočet Akademie věd je kolem 7 miliard korun.

Our World in Data má novou stránku zaměřenou na statistiky o AI. Zajímavostí může být, že počet základních výpočetních operací, tzv. floating-point operations (FLOPs), používaných k tréninku velkých AI je nyní měřitelný v jednotkách molů — mol je přibližně počet molekul v makroskopickém množství látky. Stejně jako se u makroskopických množství atomů objevují emergentní, na malých počtech neviděné efekty, tak podobně můžeme vnímat emergenci komplexních kognitivních vzorců v obřích neuronových sítích dnes, proti jejich malým verzím, které byly běžné před léty.

Geoffrey Hinton, jeden z pionýrů hlubokých neuronových sítí a nositel Turingovy ceny za téže (ekvivalent Nobelovy ceny v počítačové vědě), představil nový učící algoritmus, který má podle něj potenciál nahradit backpropagaci — nejtypičtější způsob učení umělých neuronových sítí. Velkým problémem backpropagace je, že je extrémně nepravděpodobné, že jde o učící algoritmus, který využila evoluce pro stavbu biologických neuronových sítí jako je například lidský mozek

Vyšla nová verze oblíbené knihovny pro automatickou diferenciaci a strojové učení, PyTorch 2.0. Mimo jiné nabízí nově funkci

torch.compile, která automaticky optimalizuje strojově učící modely napsané v PyTorch.

Líbilo se vám třetí vydání newsletteru Pokrok v AI? Odebírejte ho přímo do vaší emailové schránky a podpořte tím mojí práci!

Můžete ho také sdílet s přáteli na sociálních sítích.

Napsal Stanislav Fort, editovala Kristina Šůsová.

Čekal bych že cena tréningu modelů bude spíše klesat. Optimalizace bude kompenzovat nárůst velikosti dat.