👋 Pokrok v AI – newsletter č. 34

Tentokrát píšeme o dopadu AI na kognitivní funkce, škálovacích zákonech pro samořízení a AGI v politice.

Vítejte ve třicátém čtvrtém vydání našeho newsletteru Pokrok v AI, ve kterém shrnujeme nejnovější poznatky a vývoj v oblasti používání umělé inteligence (AI), strojového učení (ML) a AI policy a regulace.

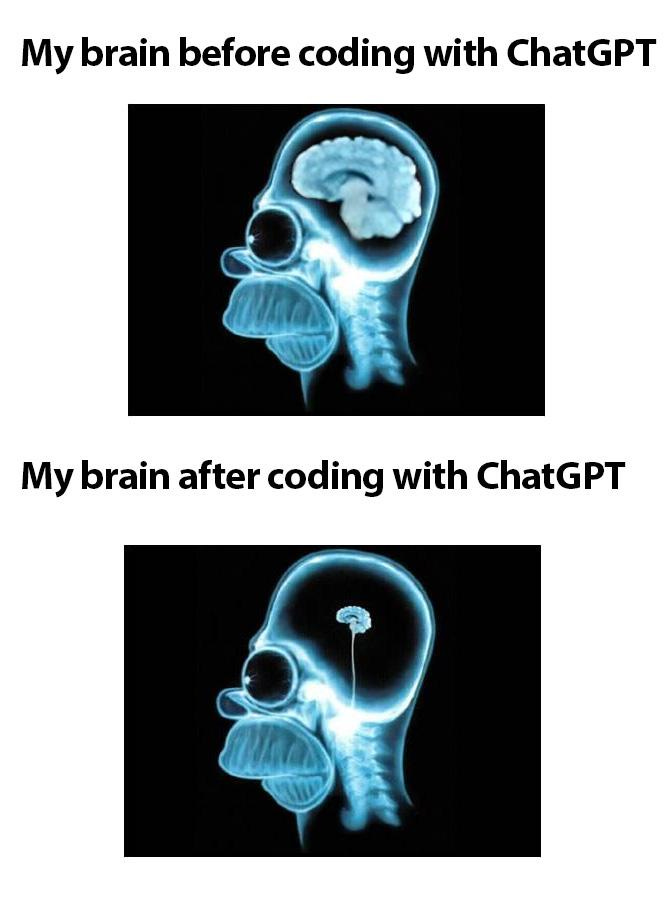

🧠 Hloupneme kvůli AI?

V rámci diskuze Když generace táhnou za jeden provaz, kde Kristina v červnu vystoupila, došlo i na téma AI modelů a toho, jak ovlivňují naše dovednosti. V oblasti psychologie už se ujal termín cognitive offloading (tedy kognitivní odkládání), kdy lidé místo vlastní kognitivní práce zadají své úkoly umělé inteligenci. Vlny kolem této otázky nyní rozvířil článek z MIT Media Lab, který tvrdí, že konzistentní používání velkých jazykových modelů (LLM) k plnění úkolů (v tomto případě psaní esejí) oslabilo propojení v mozku a způsobilo úpadek “na nervové, lingvistické i behaviorální úrovni.” Byť se tento článek okamžitě dostal do titulků médií jako potvrzení toho, že AI škodí lidskému mozku, realita je trochu jiná.

Jak známý vědec a popularizátor AI ve vzdělávání Ethan Mollick píše, správná interpretace tohoto článku je, že pokud studenti s AI podvádějí, méně se naučí, což je poměrně očekávatelný závěr. Když nějakou dovednost netrénujete a spoléháte se na externí nástroj, pravděpodobně se v ní nezlepšíte. Zároveň zmiňuje i významné slabiny v metodologii tohoto článku. Vyvozovat z něj tedy, že AI “poškozuje mozek” je značně přehnané a hloupé.

Zajímavějším příspěvkem na toto téma je článek od švýcarského vědce Michaela Gerlicha, který se věnuje dopadu AI na kritické myšlení a právě kognitivnímu odkládání. V rámci své studie potvrzuje hypotézu, že časté používání AI koreluje s omezenějším kritickým myšlením, což je spojené právě s kognitivním odkládáním. Zdůrazňuje tak, že používání AI ve výuce by mělo proces učení doplňovat, ne nahrazovat. Byť má tato studie bohužel také určité limitace, jako velikost a možné zkreslení vzorku, či spoléhání na vlastní hodnocení (self-reporting), může sloužit jako vstupní analýza pro další vědce a vědkyně, kteří se tomuto tématu budou věnovat. Jak rádi zmiňujeme, psychologie by se dopadům AI měla věnovat o hodně víc, než se aktuálně věnuje, protože o zajímavé (a důležité) otázky v této oblasti určitě není nouze.

🚗 Škálovací zákony pro samořízení

Škálovací zákony (anglicky scaling laws) jsou v hlubokém strojovém učení jedním z nejpodstatnějších výsledků posledních let. Ve zkratce jde o to, že čím více má neuronová síť parametrů (něčeho, co by se v sítích biologických mohlo přirovnat k synapsím mezi neurony) a na čím více datech trénuje, tím lepší je. Toto empiricky pozorované pravidlo je až nečekaně spolehlivé — když například 2x zvětšíme jazykový model, dokážeme hodně spolehlivě říci, jak dobrý bude v úloze, na kterou přímo trénuje, tedy v predikci dalšího slova v textu.

Mimo jazykové modely tento trend nebyl až tak zřejmý. U klasičtějších úloh umělé inteligence, jako je plánování cesty vozidla po mapě, ho lidé už skoro vůbec nečekali. V zajímavém propojení mezi fundamentálním studiem strojového učení a veskrze praktickou doménou vývoje samořídících aut nyní společnost Waymo, která je dnes nejúspěšnějším provozovatelem veřejně dostupných samořídících taxíků, publikovala velice zajímavý vědecký článek a s ním spojený blog post. Ve své studii ukazují, že škálovací zákony fungují i pro samořídící auta!

Jejich příspěvek předkládá škálovací zákony pro plánování pohybu vozidla a předvídání chování ostatních účastníků provozu, což jsou dvě klíčové dovednosti samořídících vozidel. Důsledkem je, že čím více dat Waymo uvidí a čím více výpočetního výkonu použije na trénink, tím lepší v řízení bude. A protože už dnes je Waymo 10x bezpečnější než lidský řidič v ekvivalentních podmínkách (o čemž jsme psali v našem newsletteru číslo 27), máme se na co těšit.

Waymo, které je vlastněné společností Alphabet (majitel Googlu), dnes operuje autonomní vozidla v pěti amerických městech: Phoenix, San Francisco, Los Angeles, Austin a Atlanta. Už tedy nejde o vzácnou sci-fi kuriozitu — Waymo již před pár měsíci překročilo 250 000 placených samořídících jízd týdně a v blízké budoucnosti plánuje rapidní expanzi.

Nejhlasitějším konkurentem jsou (zatím relativně hypotetické) robotické taxíky společnosti Tesla. Narozdíl od Wayma nevyužívá Tesla lidar, který je schopen přímo měřit vzdálenosti objektů od vozu. Místo toho se spoléhá pouze na kamery, z jejichž obrazu je vzdálenost pouze odhadována. Klíčovou tezí je, že vzhledem k tomu, že člověk je schopen také řídit jenom pomocí svých dvou očí, tak i AI by měla být schopna vystačit si pouze s kamerami. Zatím se zdá, že přístup Wayma je sice možná méně ambiciózní, ale zato funguje a již dnes vozí stovky tisíc platících zákazníků bez nutnosti lidské řidiče nebo dálkové intervence. Uvidíme, jestli Tesla bude ze škálovacích zákonů, které Waymo v této studii objevilo, benefitovat také.

😮💨 AGI je ve vzduchu

V posledních měsících téma obecné umělé inteligence (AGI) pomalu proniká i mimo okruh lidí, kteří se vývoji a výzkumu AI dlouhodobě věnují. Byť je nejisté, jak a jestli se AGI v blízké budoucnosti dočkáme, chtěli bychom upozornit na tento trend, a tak přikládáme pár citátu evropských i amerických politiků z posledních měsíců.

Ursula von der Leyen, předsedkyně Evropské komise, pronesla: ,,Při projednávání současného rozpočtu jsme se domnívali, že se umělá inteligence přiblíží lidskému rozumu až kolem roku 2050. Nyní očekáváme, že se tak stane již příští rok.” (originál: “When the current budget was negotiated, we thought AI would only approach human reasoning around 2050. Now we expect this to happen already next year.”) Jen pár let zpátky by bylo nepředstavitelné, že o tomto tématu přemýšlejí vysoce postavení evropští politici.

Při nedávném slyšení v americkém kongresu zase zástupkyně Jill Tokuda (za stát Havaj) mluvila o existenčních rizicích spojených s umělou inteligencí a o riziku ztráty kontroly nad pokročilým AI systémem v autoritářských státech jako jsou Čína či Rusko. To, že se podobná témata dostávají do debat amerického Kongresu, je naprostou novinkou a budeme dále pozorovat, jestli to bude mít dopad i na americkou AI regulaci. Pokud si totiž myslíte, že AI systém, nad nímž ztratíme kontrolu, může být existenčně nebezpečný, tak byste měli nastavit nějaká pravidla pro jeho vývoj i použití.

⚡Rychlé odkazy a myšlenky

🎙️V červnu s námi vyšel rozhovor v podcastu Cinkátko. Hodně nás to bavilo a určitě doporučujeme poslech.

🎧 Audio záznam z naší debaty o AI a biologickém pokroku organizované magazínem Respekt najdete zde.

🇺🇸 Na podzim jsme psali o kalifornském AI zákoně SB 1047, který nakonec neprošel, protože ho guvernér Newsom vetoval. Nedávno byl ale podobný zákon (RAISE Act), který se věnuje katastrofickým scénářům kolem AI, schválen ve státě New York.

💸 Společnost Meta (majitel Facebooku či Instagramu) investovala $15 miliard do startupu ScaleAI a jejího CEO Alexandra Wanga, který by měl nyní vést Superintelligence tým v Meta. Tato investice ale mimo jiné vyvolává v USA různé národně-bezpečnostní otázky, neboť startup ScaleAI měl kontrakty s americkým Ministerstvem obrany (DoD) a zůstává otázkou, jak je teď bude schopný naplňovat.

🦅 Moratorium na regulaci týkající se AI v USA, o kterém jsme psali v minulém vydání, neprošlo mimo jiné díky příspěvku think tanku LawAI, pro který Kristina aktuálně pracuje.

👮 Imigrační opatření nové americké administrativy, především proti čínským studentům, vzbuzují otázky, jaký budou mít dopad na AI výzkum a STEM obory v USA obecně.

🇪🇺 Veřejná konzultace Evropské komise k otázce vysoce rizikových AI systémů je otevřena do 18. července. Vyjádřit se můžete i vy!

Kristina aktuálně spolupracuje s různými organizacemi v oblasti AI governance včetně Google DeepMind. Tento newsletter nevyjadřuje názory žádného z jejích klientů.

Líbilo se vám třicáté čtvrté vydání newsletteru Pokrok v AI? Odebírejte ho přímo do vaší emailové schránky a podpořte tím naši práci!

Můžete ho také sdílet s přáteli na sociálních sítích. Jsme vděční za každé sdílení!

Napsali Stanislav a Kristina Fort.