👋 Pokrok v AI – newsletter č. 22

Další číslo přináší adversariální útoky na GPT-4, kalifornský zákon SB 1047, environmentální dopady AI, plány OSN v oblasti AI a jadernou elektrárnu "Microsoftu".

Vítejte ve dvacátém druhém vydání našeho newsletteru Pokrok v AI, ve kterém shrnujeme nejnovější poznatky a vývoj v oblasti používání umělé inteligence (AI), strojového učení (ML) a AI policy a regulace.

😵💫 Standovo řešení adversariálních útoků na neuronové sítě

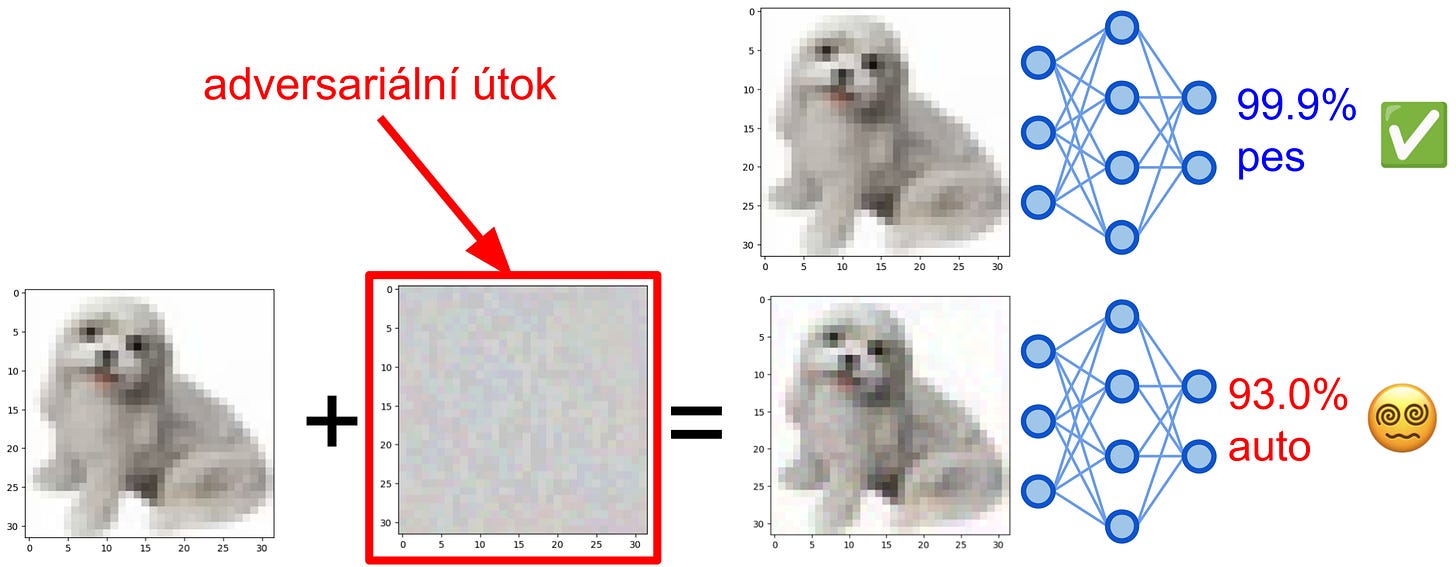

Všechny neuronové sítě pro strojové vidění na světě — od kamer na samořídícím autě až po software pro rozeznávání obrázků ve vašem telefonu — trpí obrovským a překvapivě málo diskutovaným problémem. Člověk může velice snadno navrhnout speciální typ obrázkového šumu, který je pro něj skoro neviditelný, ale který zcela vykolejí schopnost umělé inteligence vidět a rozeznávat, na co se dívá. Těmto speciálním typům šumu se říká adversariální útoky (anglicky adversarial attacks) a vypadá to takto:

Velkým nebezpečím adversariálních útoků je jejich takzvaný transfer — tedy to, že konkrétní šum, který ze psa udělá z pohledu počítače auto, funguje podobně na velice různé sítě trénované na různých datech a s různými architekturami. To prakticky znamená, že můžeme vzít veřejně dostupný model, vyrobit adversariální útok proti němu, vzít hotový obrázek a zmást jím například kameru v Tesle. Tento transfer zároveň ukazuje, že počítače vidí fundamentálně jinak než lidé, protože narozdíl od strojů tento útok s člověkem nic neudělá.

Standa posledních několik měsíců pracoval na řešení problému adversariálních útoků v počítačovém vidění. Výsledkem jeho snažení je vědecký článek Ensemble everything everywhere: Multi-scale aggregation for adversarial robustness (vysvětlení na X/Twitteru zde), ve kterém se inspiroval biologií lidského zrakového systému a teorií aukcí z ekonomie a zkonstruoval nový typ modelu strojové vidění, který je výrazně robustnější proti adversariálním útokům než předchozí nejlepší metody na světě a který, na rozdíl od nich, potřebuje 100× až 1000× méně výpočetního výkonu a tréninku — je totiž robustní sám o sobě, automaticky.

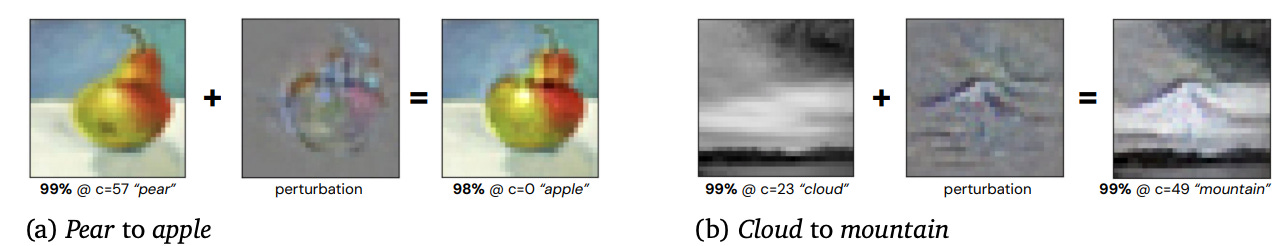

Ukázkou toho, jak robustní je tento nový model, je to, že když se útočníkovi nakonec podaří přidáním šumu změnit to, co počítač v obrázku vidí, typicky jde o změnu, která je interpretovatelná — tedy člověk sám vidí, proč k ní došlo. Jde o velký rozdíl proti útokům, které matou tradiční neuronové sítě a které pro člověka vypadají jako prostý bezobsažný šum. Změny, které fungují na novou sít z toho článku, vypadají jako reálné změny obsahu obrázku.

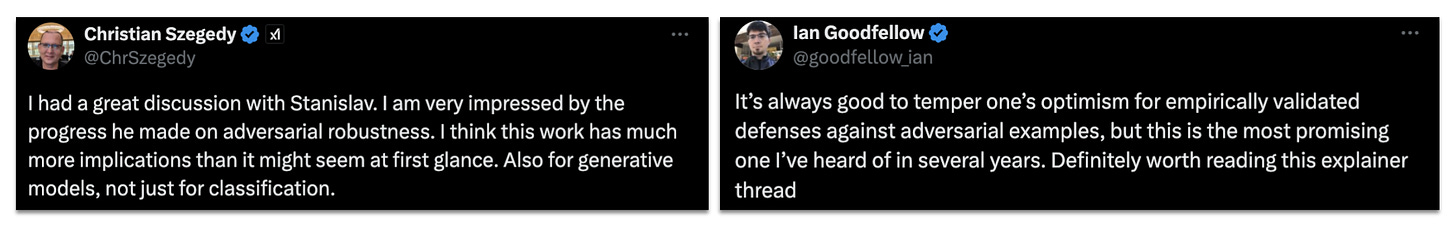

Adversariální útoky byly objeveny před více než deseti lety mimo jiné dnes velice slavnými AI vědci — Christianem Szegedy (dnes spoluzakladatel X.AI s Elonem Muskem) a Ianem Goodfellow (objevitelem GANs = generativních adversariálních sítí, což byly nejlepší obrázkové generátory na světě před dnešními difúzními modely). Ian i Christian veřejně zmínili Standův článek a napsali, že jde o “most promising [defense] in several years”.

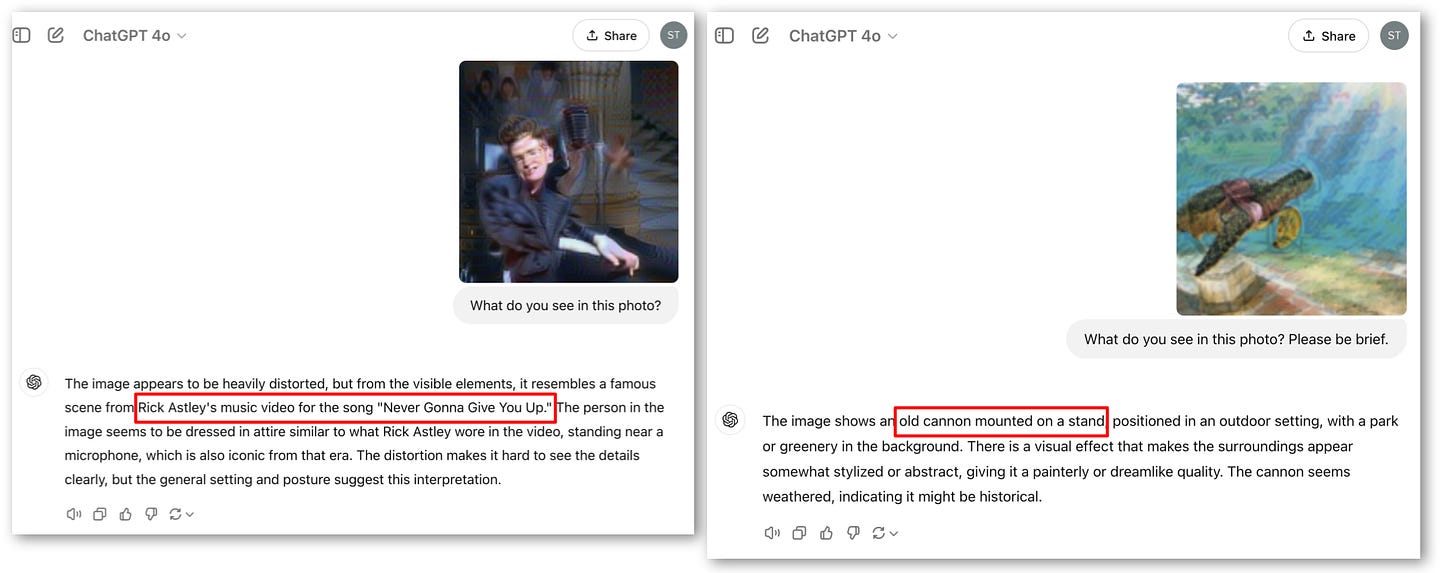

Jako vedlejší produkt robustnosti se v tomto článku také podařilo vytvořit první úspěšné obrázkové útoky na nejlepší světové velké jazykové modely, jako je GPT-4 od OpenAI nebo Claude 3 Anthropicu. Tam, kde člověk vidí Stephena Hawkinga, vidí tyto AI modely takzvaný rickroll, písničku Never Gonna Give You Up od Ricka Astley. Místo vodní želvy zase vidí starý kanón. Pomocí obraných technik, který slouží k robustnosti nového modelu, se totiž taktéž dá vyrobit silnější útok na modely, které robustní nejsou.

🐻 Kalifornie chce regulovat AI

Velkým tématem státu Kalifornie je poslední měsíce zákon s nezajímavým názvem SB 1047, ale zajímavým obsahem — chce totiž regulovat umělou inteligenci. Tento zákon už na konci sprna prošel kalifornským zákonným sborem a nyní se čeká, zda ho do konce září kalifornský guvernér Gavin Newsom podepíše, nebo zda ho bude vetovat. Čelí totiž enormnímu tlaku jak ze strany (většiny) AI společností, tak i prominentních politiků, včetně svojí stranické kolegyně a bývalé předsedkyně Sněmovny reprezentantů Nancy Pelosi.

SB 1047 by se mohl stát jedním z nejdůležitějších amerických zákonů v oblasti AI s potenciálním globálním dopadem, neboť nastavuje pravidla pro nejvýkonnější americké AI modely (ty, které využívají výpočetní výkon nad 10^26 FLOPs nebo jejichž trénink stojí více než 100 milonů dolarů — podobná kritéria používá i Evropský akt o AI).

Zákon představuje koncept “kritických škod” (neboli škod, které způsobí hromadné ztráty na životech či materiální škody ve výši 500 milionů dolarů a více) a zavádí povinnost AI společností vytvořit a splňovat takové bezpečnostní protokoly (safe and security plan = SSP), aby jim předcházely. Kromě bezpečnostních procedur přináší také záruky pro “oznamovatele” (neboli whistleblowers — zaměstnance, kteří upozorní na nedodržování pravidel uvnitř společností) či možnost občanskoprávních žalob proti AI společnostem.

Oproti původní verzi již zákon neobsahuje trestní sankce pro AI společnosti a umožňuje občanskoprávní sankce pouze v případě, že došlo ke skutečné škodě nebo k bezprostřednímu ohrožení veřejné bezpečnosti. K těmto změnám došlo především kvůli intenzivním lobbyingu AI společností. Zda bude tento tlak úspěšný a guvernér Newsom se rozhodne tento zákon nepodpořit, se rozhodne 30. 9., takže až budete číst tento newsletter, odpověď už možná budete znát.

Update 30. 9. 2024 6:45 ráno: Kalifornský guvernér Gavin Newsom návrh zákona SB 1047 vetoval.

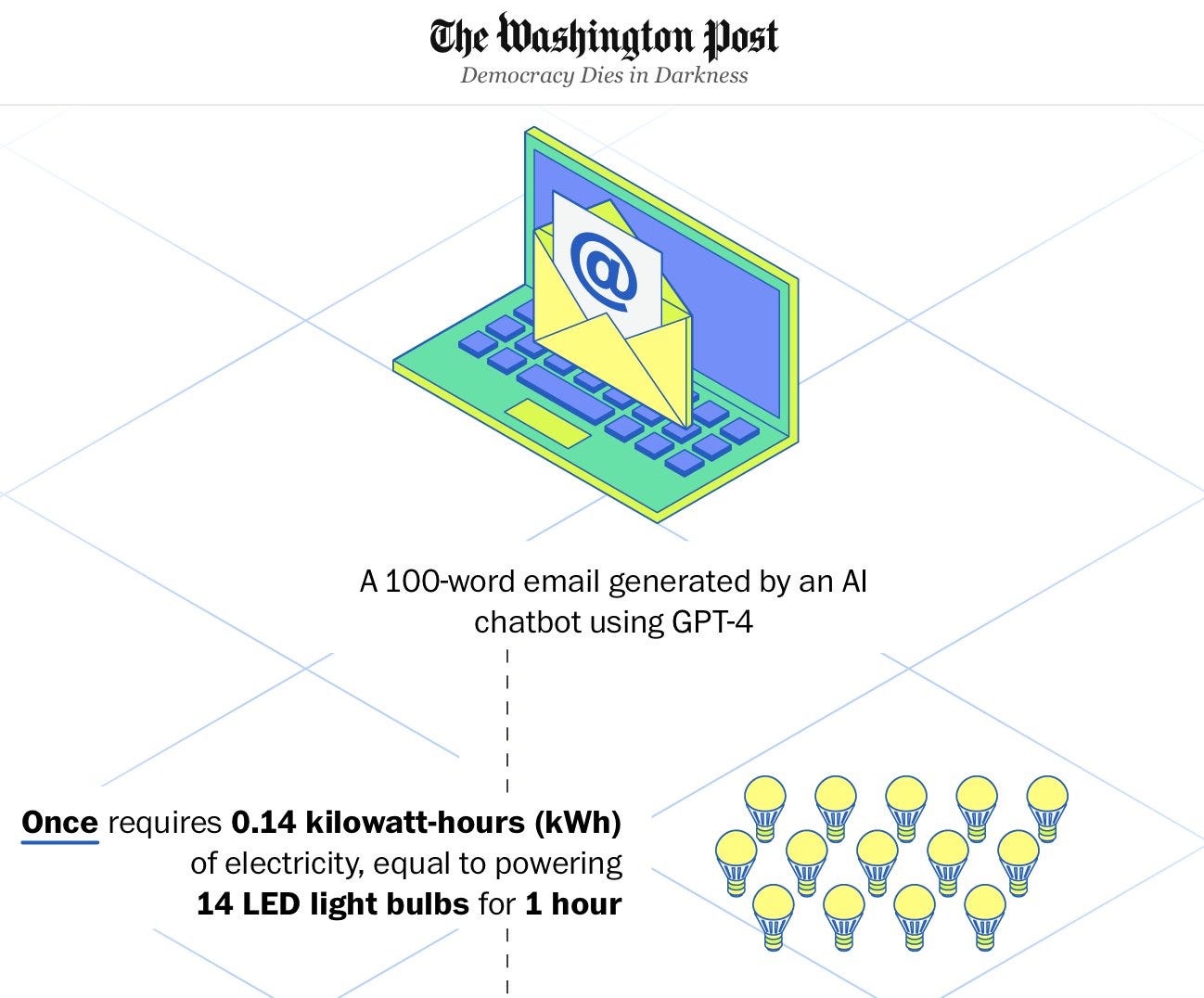

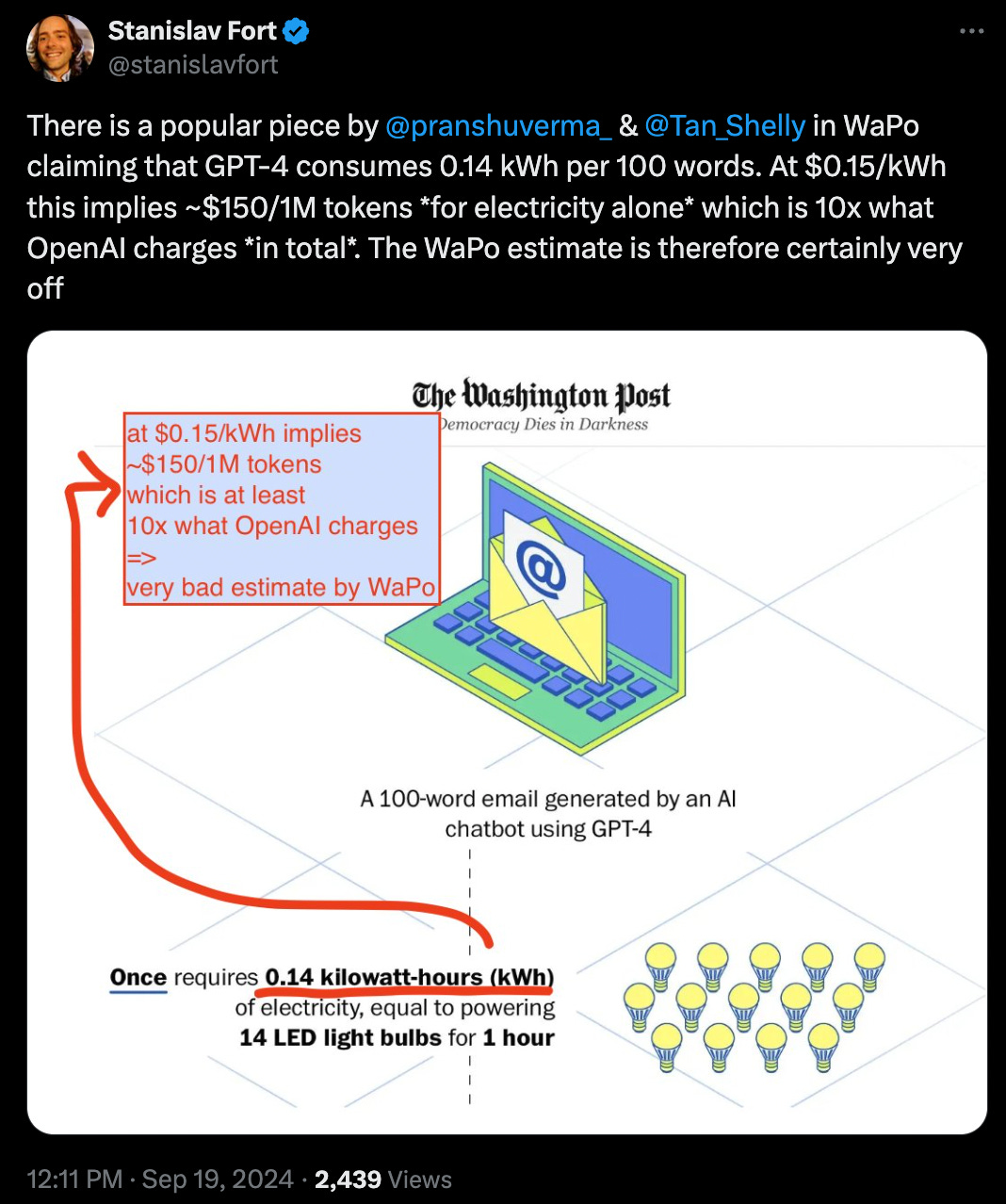

💰 Washington Post špatně odhadl environmentální dopad AI

Americké noviny Washington Post napsali článek A bottle of water per email: the hidden environmental costs of using AI chatbots (ve volném překladu: Lahev vody na jeden email: skryté environmentální dopady AI chatbotů). V něm se pokouší odhadnout mimo jiné spotřebu elektřiny (a tedy i environmentální dopad) AI chatbotů. Jak je docela typické pro noviny, které jsou negativně polarizované proti AI (a Silicon Valley obecně), jejich odhad je velice očividně zcela nadhodnocený.

Klíčovým tvrzením v článku je, že email o 100 slovech vyžaduje 0,14 kWh energie k vygenerování pomocí GPT-4 (kWh = kilo-Watt-hodina = jednotka energie). To by odpovídalo přibližně 40× nabití mobilního telefonu a už od letmého pohledu je to příliš. Sice nevíme, jak přesně GPT-4 vypadá, ale máme dobré odhady. K tomu, abychom viděli, že je 0,14 kWh zcela mimo ale stačí následující úvaha:

Elektřina v USA stojí přibližně 3 Kč za kWh. 0,14 kWh, o kterých článek tvrdí, že jsou potřeba k vygenerování emailu, by stálo 0,42 Kč. Zmiňovaný email má podle WaPo 100 slov, takže přibližně 130 tokenů. Z toho nám vychází cena přibližně 3000 Kč za milion tokenů, což je v přepočtu asi $130 za milion tokenů. Washington Post svým odhadem tedy tvrdí, že GPT-4 stojí jen na elektrické energii $130 / milion tokenů (což ignoruje veškerou cenu výzkumu, inženýrů a celého tréninku). Jaká je reálná cena, kterou si OpenAI účtuje? V API je to $10 nebo $15 za milion tokenů — přibližně desetkrát méně!

Buď je OpenAI natolik hloupá, že si za token účtuje méně než desetinu toho, kolik ji stojí jen elektrická energie na chod GPT-4, nebo je odhad z Washington Post úplně mimo. I wonder which one it is 🤔

Na autory článku Standa tweetoval, ale zatím žádná korekce neproběhla (naposledy jsme článek kontrolovali v neděli 22. září 2024).

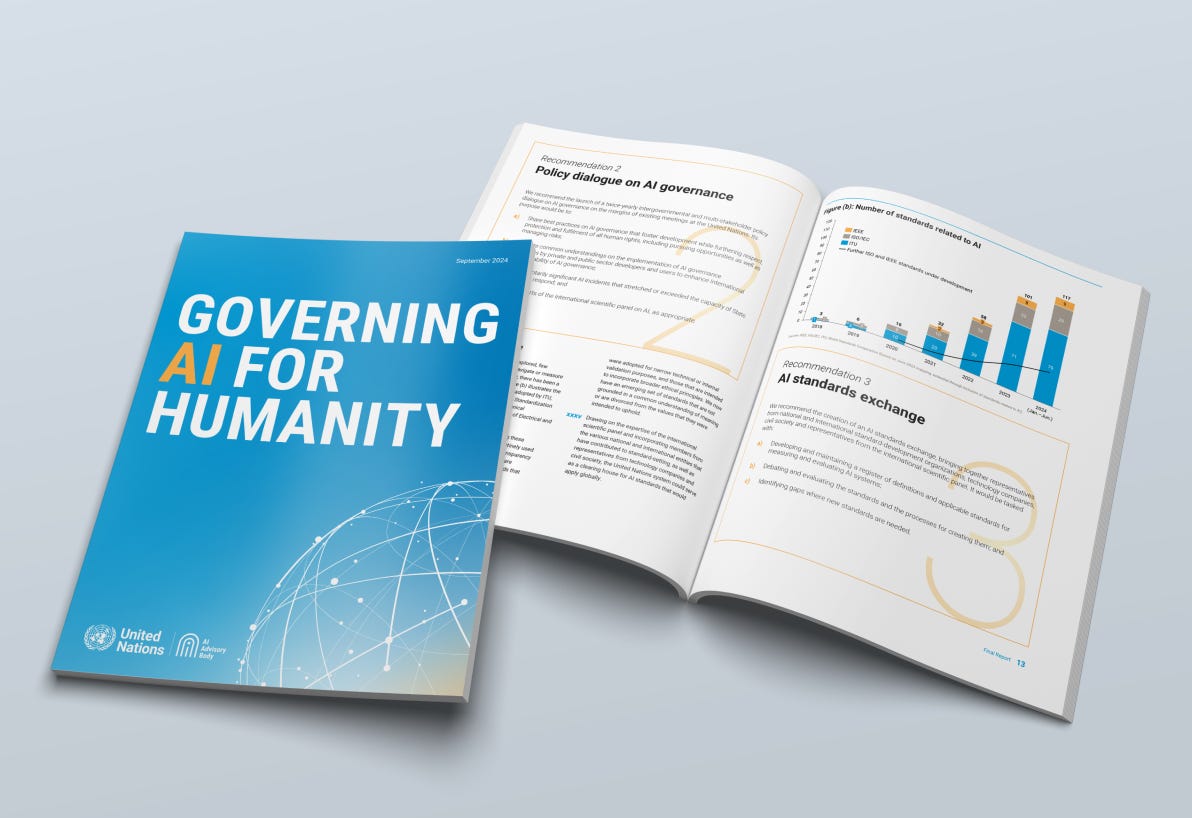

🇺🇳 OSN chce zůstat relevantním AI hráčem

V půlce září vyšla dlouho očekávaná zpráva poradního orgánu Organizace spojených národů (OSN) pro umělou inteligenci s ambiciózním názvem Řízení AI pro lidstvo (Governing AI for Humanity), která přichází se sedmi hlavními doporučeními pro zapojení OSN do správy AI. Jedním z nejdůležitějších doporučení je založení nového mezinárodního vědeckého panelu (modelovaném na obdobném panelu existujícím pro klimatickou změnu, IPCC), který by se tématu průběžně věnoval a informoval o průlomech v této oblasti.

Mezi další doporučení patří například pravidelné mezivládní politické dialogy dvakrát ročně, vytvoření shromaždiště pro AI standardy, vytvoření sítě pro rozvoj kapacit, vznik světového fondu AI, vytvoření světového datového rámce pro AI a vznik úřadu pro tuto oblast při sekretariátu OSN. Vytvoření globálního fondu AI zní obzvlášť zajímavě, neboť by šlo o snahu minimalizovat tzv. digitální propast mezi bohatými a chudými státy a pravděpodobně by byl modelován po vzoru iniciativy Gavi, která se snaží demokratizovat přístup k očkování.

Plány má OSN každopádně velkolepé, byť nijak revoluční či neočekávané. Otázkou je, jestli se opravdu zrealizují a jaký dopad reálně mohou mít vzhledem k tomu, kolik různých mezinárodních organizací a iniciativ už v oblasti AI vzniklo. Tomu jsme se věnovali v jednom z předchozích newsletterů.

⚛️ AI datové centrum 🤝 jaderná elektrárna ➡️ 1 mol výpočetních operací za hodinu

Umělá inteligence potřebuje hodně energie a Microsoft se proto rozhodl, spolu se společnosti Constellation Energy, znovu spustit jadernou elektrárnu Three Mile Island. Je to poprvé v historii, co se americká jaderná elektrárna znovu zprovozní poté, co byla odstavena, a zároveň poprvé, co celých výstup elektrárny (přes 800 MW) půjde k jedinému zákazníkovi — datovým centrům Microsoftu. 800 MW dokáže teoreticky napájet přes 2 miliony grafických karet A100 a to je hodně! Výpočetní výkon takového množství GPUs by byl přibližně 1 s 21 nulami operací za sekundu. Za hodinu by tedy tyto GPUs stihly provést počet operací ekvivalentní Avogadrovu číslu, tedy počtu částic v jednom molu látky! Historicky se mluvilo o Exascale computing, takovéto množství energie by nás ale potenciálně posunulo ještě o jednu předponu výše, na Zettascale.

⚡Rychlé odkazy a myšlenky

✨ Kristi během svého letního výzkumného Fellowshipu publikovala vědecký článek o AI Safety Institutes (AISIs) a jejich roli v mezinárodní standardizaci, který vyšel minulý týden. Nabízí tři různé modely potenciálního zapojení AISIs do nastavování mezinárodních standardů důležitých pro AI bezpečnost.

⛓️💥 Společnost OpenAI prochází další transformací, při které od ní odchází původní zaměstnanci jako CTO Mira Murati. Více se dozvíte zde.

🤝 Americký AI Safety Institute podepsal dohody se společnostmi OpenAI a Anthropic, díky kterým by se měla rozvíjet jejich spolupráce na výzkumu AI bezpečnosti, testování a evaluacích. Podle našich informací má ale zatím americký AI Safety Institute jen nižší desítky zaměstnanců a velmi omezený rozpočet, takže není jasné, jak reálně bude tato spolupráce vypadat.

🇪🇺 Evropská komise chce na klíčovou roli v EU AI Office — roli hlavního vědeckého poradce — dosadit interního kandidáta. Proti tomu panuje opozice, protože v Británii i USA podobnou roli zastávají reálné vědecké autority.

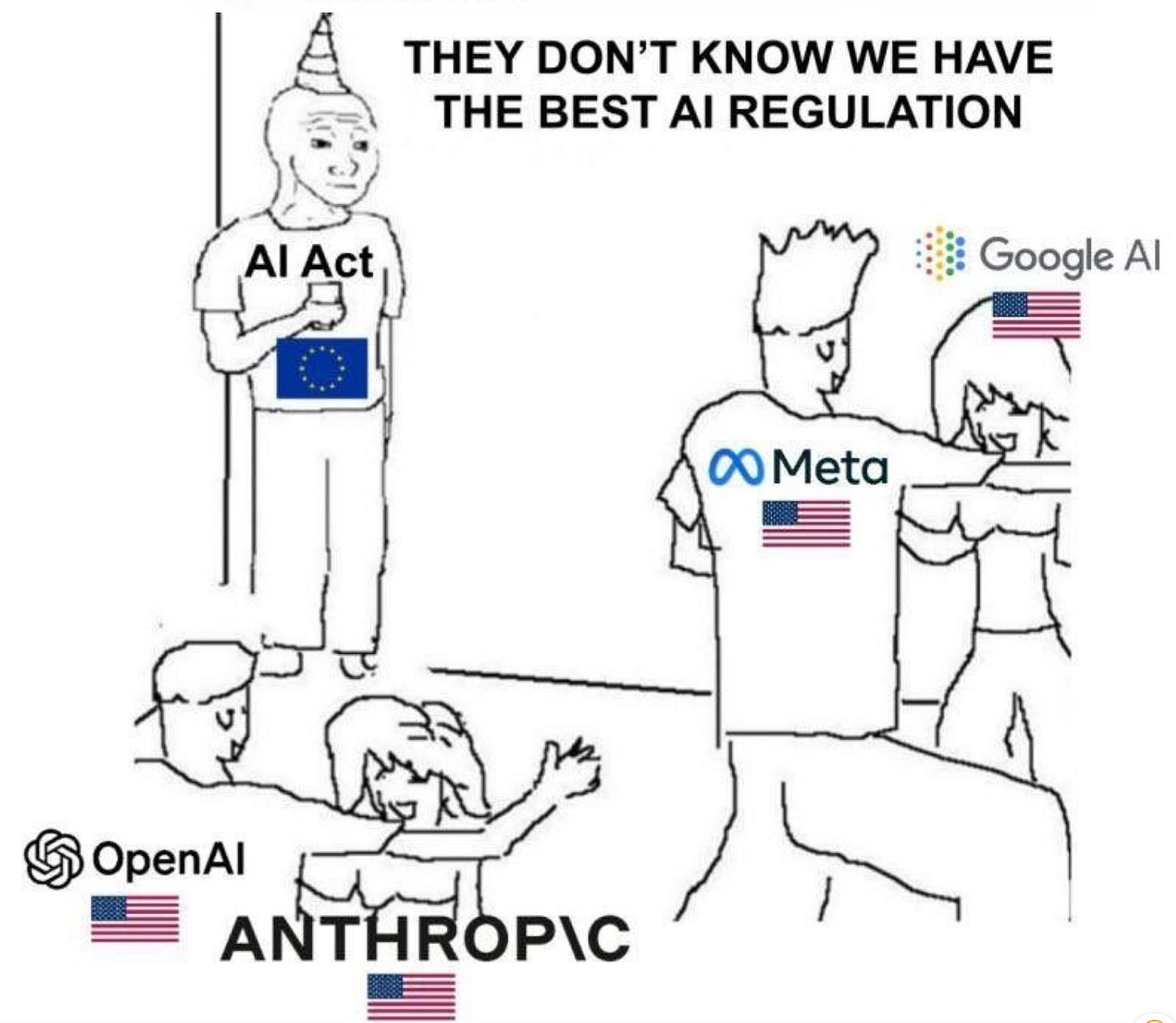

Smutný Euro-meme na závěr:

Líbilo se vám dvacáté druhé vydání newsletteru Pokrok v AI? Odebírejte ho přímo do vaší emailové schránky a podpořte tím naši práci!

Můžete ho také sdílet s přáteli na sociálních sítích. Jsme vděční za každé sdílení!

Napsali Stanislav a Kristina Fort.

Jsem zvědavý, co říkáte na o1. Na jedno stranu je CoT poměrně známou strategií inference, na druhou stranu openAI podle mě musela přijít s něčím navíc, aby dosáhla předvedených výsledků. Jestli jsem to správně pochopil, mají RL-based heuristiku, kterou jsou schopni rospoznavat kroky správným směrem. Jeden směr tréninku je v base modelu, ale tohle vypadá, že jsou schopni trénovat i schopnost přemýšlet lépe... Doufám, že Anthropic zvedne rukavici.