👋 Pokrok v AI – newsletter č. 28

Dnešní vydání je cestou kolem světa zachycující AI novinky z Británie, Spojených států i Číny. Obzvlášť pokud nevíte, co si myslet o dění kolem čínské společnosti DeepSeek, čtěte dál!

Vítejte ve dvacátém osmém vydání našeho newsletteru Pokrok v AI, ve kterém shrnujeme nejnovější poznatky a vývoj v oblasti používání umělé inteligence (AI), strojového učení (ML) a AI policy a regulace.

🐋🇨🇳🐋 Kam kráčíš, DeepSeeku?

DeepSeek je čínská AI laboratoř, který vznikla v roce 2023 jako “vedlejší” projekt Lianga Wenfenga, mnohočetného startupisty a spolu-majitele investičního fondu High-Flyer. DeepSeek je již relativně velká společnost a samotný vědecký článek představující nový model specializovaný na uvažování (reasoning), DeepSeek R1, má kolem 200 autorů, což vskutku není vůbec málo. DeepSeek od svého založení před dvěma lety začal publikovat čím dál tím lepší open source velké jazykové modely a byl obecně v hledáčku hodně lidí, kteří detailně sledují vývoj AI na technické úrovni.

Z našeho pohledu nastal velký průlom již před měsícem, kdy DeepSeek publikoval svůj model V3. V asociovaném vědeckém článku byla ve velkém diskutovaná efektivita tréninku. Pro nedávná léta, během kterých se výzkum AI posunul do méně veřejné fáze, se autoři relativně netradičně rozepsali o velkých technických detailech toho, jak které zlepšení funguje. Velká míra otevřenosti mohla být částečně motivovaná touhou posunout hranici vědění lidstva, ale není možné si nevšimnout, že stejnou strategii zvolila i západní technologická firma — Meta se svými modely Llama — která byla taktéž pozadu proti proprietárním AIs v oboru.

Model R1, který po V3 následoval, byl pro svět velkým šokem — prolomil takzvanou “normie bariéru”, což pro nás prakticky znamená, že se o něm třeba psalo na Novinkách a že nám o něm říkali naši rodiče. Vzhledem k tomu, jak velký je v této oblasti nyní informační šum, jsme se rozhodli sepsat, co si o novém modelu a jeho implikacích myslíme.

R1 je takzvaný reasoning model, tedy model specializovaný na přemýšlení. Rozdělení na “standardní” a “přemýšlecí” jazykové modely není úplně přesné. Když donutíte jazykový model odpovědět na otázku rovnou “bez omáčky”, dostanete typicky o hodně méně kvalitní výsledek, než když ho necháte nad problémem uvažovat a rozmyslet si ho. Narozdíl od člověka nemá ale jazykový model možnost něco rozmýšlet jinak než tak, že mluví. O tomto efektu jsme psali již v jednom z našich prvních newsletterů před dvěma lety, kde jsme ukázali, že pokud model nutíte odpovědět rychle, dělá podobné logické chyby jako člověk, který přemýšlí metaforickým instinktivním Systémem 1 (od Kahnemana a Tverského z jejich slavné knihy Myšlení rychlé a pomalé).

Přemýšlení “nahlas” se u jazykového modelu říká chain-of-thought, tedy něco jako řetězec myšlenek. I běžné modely jsou skrze svůj trénink pobízeny k tomu, aby takto uvažovaly, což obecně zvyšuje kvalitu jejich odpovědí. Problémem je, že takovýto trénink je obtížný a to hlavně proto, že je těžké pro něj získat vhodná data. Tato data totiž musí vypadat jako detailně rozepsané přemýšlení nad nějakým problémem a i přes to, že na internetu některé takové texty jsou, jich není mnoho (a proto také nejspíše základní modely nejsou tak dobré v přemýšlení). Kdyby se podařilo taková data generovat synteticky, tedy automaticky (strojově), byl by to v podstatě AlphaGo-moment pro přemýšlení (AlphaGo byl AI systém od Google DeepMind, který porazil světového šampiona v této slavné deskové hře hlavně skrze trénink sám proti sobě — tedy automatickým generováním “přemýšlecích” dat, na kterých pak trénoval —nevědělo se však, jak toto zobecnit z deskových her na přirozený lidský jazyk).

OpenAI byla první společností, které se (nejspíše, není to veřejně známé) podařilo problém generování přemýšlecích dat částečně vyřešit. Výsledkem byl nejprve model OpenAI o1 a později ještě OpenAI o3, které jsou výrazně chytřejší v komplikovaných intelektuálních otázkách než například GPT-4 (vzhledem k tomu, že většina lidí se ale jazykových modelů na nic tak komplikovaného neptá, veřejnost si toho do velké míry nevšimla). Protože si OpenAI uvědomovala, že mít přístup k tomu, jak model problém detailně řeší, je přesně ten typ dat, který bylo tak těžké vygenerovat, tak chain of thought svých modelů uživatelům neukazovala (k nechuti mnohých).

DeepSeek R1 je open source verze hodně podobné věci. Jeho týmu se podařilo zprovoznit systém postavený na reinforcement learningu (RL), který dokázal synteticky generovat přemýšlecí data, na kterých trénovat. Podobné pokusy byly prováděny během posledních několik let v akademických i průmyslových laboratořích, ale zdá se, že k tomu, aby to prakticky fungovalo, bylo potřeba mít hodně kvalitní základní model, což byl v tomto případě právě nejspíše DeepSeek V3 oznámený před měsícem.

Ve vědeckém článku k R1 se mimo jiné dočteme, že stačí kolem 800 000 ukázek kvalitního přemýšlení k tomu, abychom z “normálního” jazykového modelu udělali model “přemýšlecí”. 800 000 ukázek kvalitního přemýšlení přesně takového typu, který DeepSeek R1 před uživateli, na rozdíl od OpenAI, neschovává — není možné nevidět, že tohle je začátek revoluce, ve které každý základní model bude brzy dobrý v přemýšlení. Zároveň je vysoce pravděpodobné, že DeepSeek úplně to samé dělá právě teď, při tvorbě ještě silnějšího modelu.

Kolem DeepSeek R1 se vynořilo hodně nekvalitních spekulací a panických pohybů na trhu. Co si o tom myslíme? Jedna z věcí, o které se kolem R1 hodně mluvilo, byla schopnost modelu opravit během přemýšlení sama sebe. Toto není nové a příklady podobného chování jsme už sledovali několik let. Například před dvěma lety jsme toto chování demonstrovali v našem newsletteru.

Symbolická cena $5M, o které se často mluví, opravdu není v oblasti AI moc a je nesporné, že DeepSeek pod vahou sankcí a omezených výpočetních zdrojů přišel na zlepšováky, které zvyšují efektivitu tréninku proti open-source modelům na západě (víte ale, jak efektivní jsou velké modely interně v OpenAI, Anthropicu nebo Google DeepMind?). Velkou chybou by ale bylo vnímat toto číslo v nesprávném kontextu. Když ho porovnáváme například s hodnotou OpenAI jako firmy (řádově $100B = $100 000M, tedy 20 000-krát tolik) je to sice veliký kontrast, ale je to něco podobného, jako bychom porovnávali cenu jednoho letadla s hodnotou firmy, která ho vyrábí. Finální trénink konečné verze jednoho jediného modelu mohl být relativně levný, ale to není jediný výdaj, který je relevantní.

Celková cenovka, o které se v kontextu AI často mluví, sice zčásti pokrývá náklady na trénink modelu — ty jsou fixní a jakmile je model natrénovaný, tato položka už nepřibývá. Druhým a často ignorovaným nákladem je takzvaná inference, tedy běžné použití modelu — to, když mu pošlete nějaký text a on vám začne odpovídat. Hardware, na kterém inference běží, je typicky ten samý, na kterém se trénuje, a je i podobně nákladný. Pro představu — koupit si jednu grafickou kartu Nvidia A100 (dnes již starší generace) stojí přibližně $10k až $20k. Jen kapitál potřebný ke stavbě datového centra o desítkách tisíc těchto karet (běžná velikost), by stál minimálně stovky milionů až miliardy dolarů a to jen v ceně GPUs samotných. A toto jsou právě náklady, na které AI společnosti potřebují velké množství kapitálu. Trénink je nezanedbatelnou složkou tohoto celku, ale jen abychom si všichni mohli povídat s GPT-4o nebo Claude 3.5 Sonnet je potřeba obrovské množství výpočetního výkonu jen na samotnou inferenci.

DeepSeek R1 z našeho pohlede ještě více zdůrazňuje význam a důležitost výpočetního výkonu a obecně si myslíme, že reakce trhu je hodně iracionální (protože trhy nejsou efektivní). Řekněme, že je pravda, že DeepSeek R1 přišel na nová zlepšení neuronové architektury nebo třeba tréninkového algoritmu a na tu samou úroveň inteligence se dostane s polovinou výpočetních operací. Proč by tohle mělo znamenat, že prostě ten samý výpočetní výkon nyní nepoužijeme k tréninku ještě lepšího modelu? V praxi to dokonce vypadá ještě extrémněji a tento jev má jméno Jevonsův paradox — čím větší efektivita využití, tím větší poptávka, tím větší celkové využití zdroje. Funguje tedy západní embargo na GPUs? Do velké míry určitě ano! Sám CEO DeepSeeku říká, že jejich největším limitem byl právě výpočetní výkon, jak jsme zmiňovali v posledním vydání našeho newsletteru. Zároveň ve vědeckém článku píší, že ještě v žádném případě nenarazili na strop výkonu modelu, pokud by měli výpočetního výkonu víc.

DeepSeek R1 je pozoruhodný model a vzhledem k jeho otevřenosti je z našeho pohledu skoro jisté, že vstupujeme do nové éry, kde “přemýšlení” bude o hodně šířeji dostupné ve všech jazykových modelech díky proliferaci vysoce kvalitních syntetických dat, které R1 generuje a před uživateli neschovává. Naše predikce je, že zájem a hlad po výpočetním výkonu půjde nahoru a že je absolutně jisté, že (pokud je ještě neměli) skončí všechny zlepšováky efektivnosti, na které DeepSeek přišel, v celém spektru modelů ostatních společností. Budeme určitě žít v zajímavé době. 🐋

💪 AI vpřed, říkají Briti

Jednou z nejzajímavějších AI novinek posledních týdnů bylo jednoznačně představení nového britského AI Opportunities Action Plan (tzn. Akčního plánu pro AI příležitosti), který obsahuje 50 doporučení, jak pomoci Británii využít příležitosti nabízené AI. Tento plán byl přijat aktuální labouristickou vládou a zároveň získal podporu zástupců AI sektoru v Británii, včetně lidí jako Demis Hassabis, zakladatel DeepMind a nositel Nobelovy ceny. Pokud se tento kvalitně sestavený plán podaří Británii plnit, věříme, že mají dobrou šanci pokračovat na cestě k dominantní pozici v AI světě.

Mezi klíčová doporučení patří například budování infrastruktury pro data centra díky vytvoření tzv. AI Growth Zones (zóny pro AI růst), které by měly mít speciální zrychlená řízení. Další doporučení se věnují sběru dat, která jsou pro trénování AI klíčová, přitahování AI talentu do UK pomocí zlepšeného imigračního systému i nových stipendijních programů a posílení klíčových institucí jako jsou vládní výzkumná agentura ARIA či AI Safety Institute (AISI, Kristina na ně dokonce napsala vědeckou studii).

“Zárukou kvality” pro tento plán je zajisté i to, že se pod něj podepsal Matt Clifford, sériový podnikatel a člověk, který byl zodpovědný za první AI Safety Summit, jež se konal v roce 2023 v Bletchley Park. Ten byl totiž při příležitosti představení tohoto plánu jmenován poradcem pro AI premiéra Starmera, a proto bude na implementaci tohoto akčního plánu dohlížet. Oba jsme Matta Clifforda loni v létě potkali a můžeme potvrdit, že je to muž na správném místě. Budeme proto pozorně sledovat, jak se britský, už teď poměrně dobře rozjetý, AI ekosystém dál rozvíjí. (Líbilo by se nám také, kdyby se zbytek Evropy v Británii inspiroval.)

⚠️ Poslední kroky prezidenta Bidena

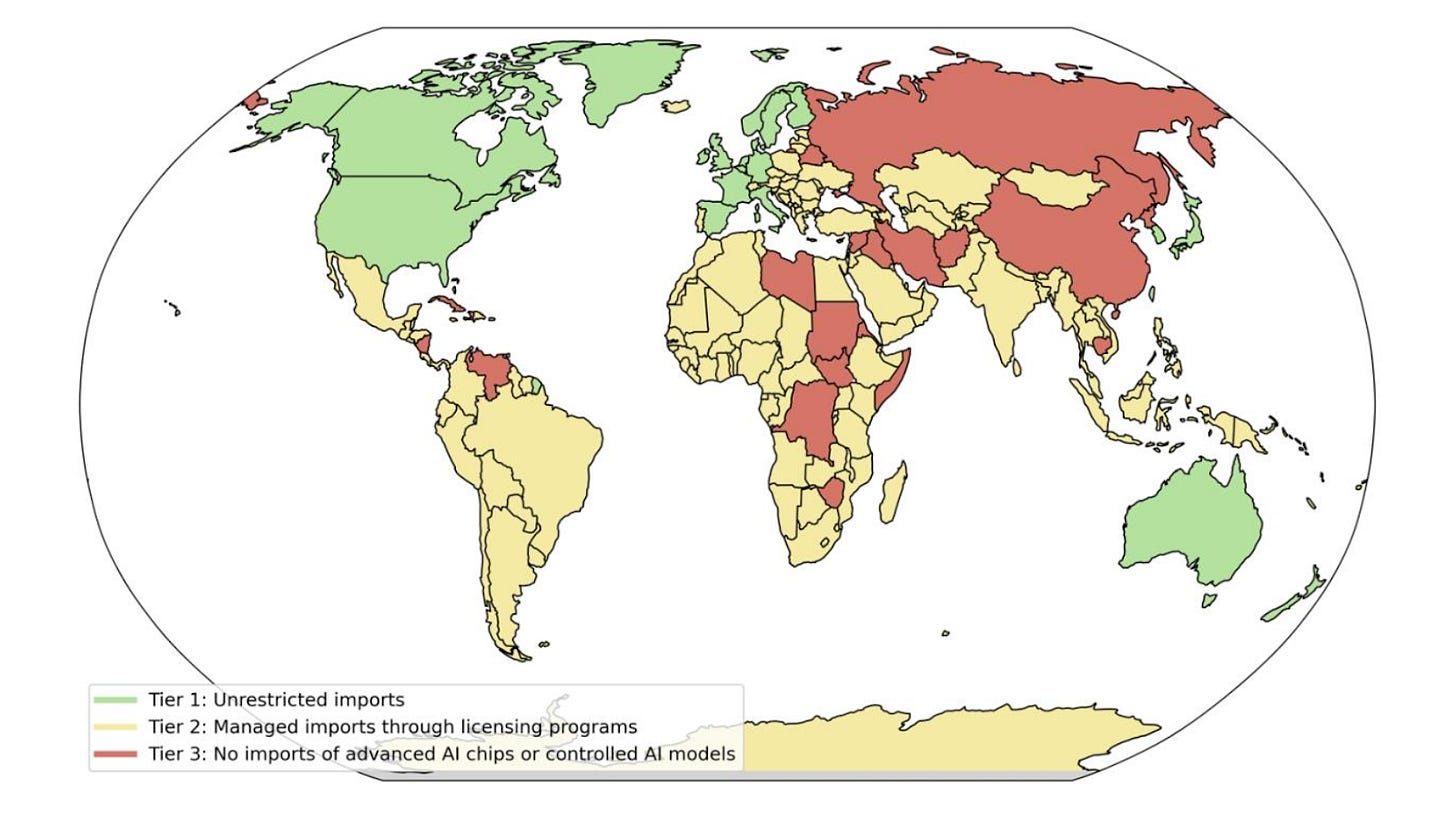

Poslední týdny v kanceláři prezident Biden věnoval i umělé inteligenci, neboť představil tzv. Rámec pro šíření AI (Framework for AI Diffusion), což je balíček zaměřující se na představení nových exportních pravidel týkajících se pokročilých amerických čipů a klíčových parametrů AI systémů (tzv. modelových vah). V rámci třístupňového systému představuje omezení prodeje AI čipů používaných v datových centrech.

V nejvyšší kategorii bez jakýchkoliv omezení je 18 spojenců USA jako jsou Austrálie, Kanada, Nový Zéland, Velká Británie, Japonsko, Nizozemsko, Španělsko, Norsko či Tchajwan. Česko je součástí druhé kategorie, která obsahuje většinu světa (zhruba 150 států). Tato kategorie umožňuje nakoupit pouze 50 000 čipů do roku 2027, případně dvojnásobek, pokud daný stát uzavře s USA speciální smlouvu. Poslední třetí kategorie obsahuje státy, které čelí americkému embargu, jako Rusko, Írán, Severní Korea či Čína.

Reakce uvnitř USA na tento nový balíček se různí — někteří chválí omezení exportu pokročilých čipů, což podle nich posílí americké prvenství v AI, jiní tvrdí, že balíček zbytečně vytváří “umělý pocit nedostatku” u amerických spojenců a oslabuje americký polovodičový průmysl. Aktuálně není jasné, zda tento balíček nová americká administrativa v čele s prezidentem Trumpem zachová či zruší. V každém případě ale dobře ilustruje důležitost pokročilých AI čipů na vývoj v oblasti AI a jejich klíčovou roli v případném “AI závodě”.

⚡Rychlé odkazy a myšlenky

🤔 Záleží Elonovi pořád na bezpečnosti AI systémů, kvůli které se koneckonců chtěl soudit se společností OpenAI? Na tohle téma vyšel zajímavý příspěvek od Shakeela z Transformer.

🔍 O vlivu AI na špionáž se rozepsala bývalá zástupkyně poradce pro národní bezpečnost se zaměřením na kyber a nové technologie Anne Neuberger.

⭐ Společnost OpenAI představila ambiciózní projekt Stargate, který má mít za cíl budování AI infrastruktury ve Spojených státech. Přestože ho představili na tiskové konferenci v Bílém domě, projekt zatím nemá zajištěno nutné financování (obřích 500 miliard dolarů) a nedostane žádné peníze od americké vlády.

Líbilo se vám dvacáté osmé vydání newsletteru Pokrok v AI? Odebírejte ho přímo do vaší emailové schránky a podpořte tím naši práci!

Můžete ho také sdílet s přáteli na sociálních sítích. Jsme vděční za každé sdílení!

Napsali Stanislav a Kristina Fort.

https://www.transformernews.ai/p/does-elon-still-care-about-ai-safety by měl být správný link

> z našeho pohlede

typo