👋 Pokrok v AI — newsletter č. 8

Další vydání newsletteru Pokrok v AI je tu a čeká vás hlavně nálož novinek ze světa regulace a AI politiky, se kterou se opravdu roztrhl pytel.

Vítejte v osmém vydání našeho newsletteru Pokrok v AI, ve kterém shrnujeme nejnovější poznatky a vývoj v oblasti používání umělé inteligence (AI), strojového učení (ML) a AI policy a regulace.

🇺🇸 Spojené státy novým lídrem AI regulace?

Prezident Biden v pondělí 30. října, ještě před britským summitem o bezpečnosti AI, představil výkonné nařízení (executive order) o rozvoji a používání bezpečné a důvěryhodné umělé inteligence. Vzhledem k pomalému legislativnímu procesu v Evropské unii, která sice svoji klíčovou regulaci umělé inteligence (Akt o AI) oznámila již v roce 2020, ale stále se dohaduje na její finální podobě, tak Spojené státy EU v regulaci AI přeběhly. Byť se jedná o důležitou legislativu, výkonná nařízení jsou legislativně slabší než již zmiňovaný Akt o AI, nemají totiž sílu zákona a další prezident může takové nařízení zrušit nebo pozměnit. Zároveň je mnohem hůře vymahatelné a soustředí se tak spíš na nastavení standardů. Pořád se ale jedná o důležitý krok, neboť výkonné nařízení definuje, jak budou AI nakupovat i používat federální agentury. Také ukazuje, jak prezident Spojených států a jeho administrativa o AI přemýšlí.

Bidenovo výkonné řízení pokrývá hned několik různých oblastí AI. Mezi nejdůležitější aspekty určitě patří povinnost pro vývojáře AI sdílet výsledky bezpečnostních testů a ambice vytvořit nové standardy, nástroje a testy pro bezpečnou a důvěryhodnou AI. Nařízení se pak také věnuje zabránění vytváření nebezpečných biologických materiálů pomocí AI či snaze vytvořit podmínky pro označování obsahu generovaného AI tak, aby se dalo předejít sofistikovaným podvodům. Kromě ochrany (nejen) práv Američanů a Američanek se ale nařízení věnuje také podpoře inovací, ať už skrze pilotní Národní AI výzkumný zdroj (National AI Research Resource) nebo nabírání AI profesionálů přes Národní AI talentovou vlnu (National AI Talent Surge). Budeme tak rozhodně nadále sledovat, jak dopad tohoto výkonného nařízení, tak další regulační vývoj, neboť se tomuto tématu aktivně věnují i členové amerického Senátu.

🇬🇧 AI bezpečnost motá hlavu světovým politikům

Hlavním tématem posledního týdne měl být summit o bezpečnosti AI (AI Safety Summit), který probíhal mezi 1. a 2. listopadem ve Spojeném království a který byl britskou vládou hojně propagován. Byť byl nakonec minulý týden plný hned několika zajímavých novinek ze světa AI politiky, které britský summit o AI bezpečnosti trochu zastínily, jednalo se o důležitou akci. Program byl zveřejněn v půlce října zde a cílem bylo diskutovat především o porozumění hlavním rizikům AI modelů a zlepšování jejich bezpečnosti.

Těsně před summitem byl navíc představen dokument zhodnocující bezpečnost technologií založených na generativní AI. Jeho hlavním výstupem je, že rychlé rozšiřování a zvyšující se dostupnost této technologie téměř určitě povede k tomu, že méně sofistikovaní nebezpeční aktéři budou schopni dosáhnout předtím netušených útoků, ať už půjde o podvody, šíření obsahu se zneužíváním dětí nebo klonování hlasu. Vystoupil také premiér Rishi Sunak s projevem, ve kterém upozornil na nebezpečí spojená s AI a vyzval ke zlepšování AI ekosystému.

Na to navázaly dva dny plné jednání, z nichž vzešla Bletchley Declaration (summit probíhal v Bletchley Park, kde kdysi Alan Turing pracoval na rozluštění kódu Enigma na počítači Colossus), kterou podpořilo 28 států (mezi nimi US, EU a Čína). Deklarace se soustředí především na rizika spojená s AI a vyzývá tak k jejich společné identifikaci a vytváření politik na ně odpovídajících. Podle organizátorů summit naplnil hlavní cíle o ,,vzájemném porozumění” a Británie tak předává pomyslnou štafetu Francii, kde by se měl konat další summit příští rok. Vzhledem k aktuálně velmi roztříštěnému vzniku regulace je ale otázka, jaký bude reálný dopad podobných akcí.

💵 AI tiskne peníze a může zahojit crypto zákazníky z FTX

OpenAI je podle veřejných dohadů v diskuzích s investory, které by její valuaci mohli zvýšit na těžko uvěřitelných $80B (přibližně 1,9 bilionu korun, což je velice blízko státnímu rozpočtu České republiky na rok 2023, který činí 2,2 bilionu korun 😮). Na firmu s několika sty zaměstnanci to není málo! Její hlavní konkurent, Anthropic, před pár týdny vybral od Amazonu až $4B v investicích (valuace je typicky mnohonásobně více) a pár dní poté další $2B od Googlu, což jeho valuaci podle některých vystřelilo na $30B. (Když jsem před necelým rokem Anthropic opustil, měl méně něž 100 zaměstnanců — je možné, že na zaměstnance je to vyšší valuace než OpenAI).

Zajímavým zvratem v tomto příběhu je to, že (alleged) krypto podvodník, bývalý “nejbohatší” člověk pod 30 let a bývalý majitel krypto-burzy FTX, Sam Bankman-Fried, který stál poslední dny před soudem, v rámci Series B do Anthropicu investoval přes $500M (z části (alleged) peníze svých klientů, kteří o tom nevěděli a ani s tím nesouhlasili). Zajímavou kličkou osudu ale je, že jeho podíl v Anthropicu by dnes mohl tak vysokou hodnotu, že je možné, že zákazníci, kterým FTX po svém krachu dluží, by mohli díky této investici získat své peníze z velká části a možná i zcela zpátky.

🏝️ Yann LeCun na rozdíl od mnohých nečeká apokalypsu

Yann LeCun, jeden ze tří nositelů Turingovy ceny za hluboké strojové učení, vedoucí AI výzkumu v Meta a jeden z nejslavnějších AI výzkumníků na světě, dal interview pro Financial Times, ve kterém nesouhlasí s katastrofickými scénáři z AI. LeCun říká, že předčasná regulace umělé inteligence by mohla posílit dominanci velkých technologických společností a omezit konkurenci. Kritizuje požadavky na dohled nad AI, které považuje za projev arogance některých předních technologických firem (například OpenAI, Anthropic, Microsoft), a zdůrazňuje, že diskuze o existenčním riziku jsou předčasné, dokud nebudeme mít systémy srovnatelné se schopnostmi učit se podobné alespoň kočce.

LeCun je velkým propagátor open-source AI modelů jako prostředku ke stimulaci konkurence a rozmanitosti v oblasti vývoje a využívání AI. Během posledních let se pod jeho vedením Meta stala nejsilnějším hráčem v open-source jazykových modelech se svými LLMs jménem LLaMA a LLaMA 2. Přesto upozorňuje na některá rizika spojená s poskytováním vysoce schopných generativních modelů potenciálním nebezpečným aktérům. Navzdory skeptickým názorům na existenční rizika plynoucí z AI ale věří, že stroje budou jednoho dne inteligentnější než lidé ve většině oblastí, ale že budou sloužit k jeho podpoře a zůstanou pod lidskou kontrolou.

🇺🇳 Organizace spojených národů (OSN) organizuje AI

Organizace spojených národů (OSN) je čím dál častěji kritizována jako “zbytečná” instituce, která nepřináší žádný užitek, byť její možnost ovlivňovat mezinárodní dění samozřejmě záleží především na členských státech a moci, kterou jí svěří. OSN přesto řeší širokou škálu témat, včetně nových technologií, a není tak překvapením, že jedním z témat letošního Valného shromáždění (UNGA), které se konalo v září, byla i umělá inteligence. Vzhledem k jejímu rychlému rozvoji zaznívají hlasy, že by měl v systému OSN vzniknout orgán podobný Mezinárodní agentuře pro atomovou energii (IAEA), který by měl na starosti mezinárodní správu umělé inteligence.

Prvním krokem na této cestě je založení Poradního orgánu pro umělou inteligenci na vysoké úrovni (High-Level Advisory Body on AI), který vznikl na konci října při Úřadu vyslance generálního tajemníka pro technologie (tím je aktuálně Amandeep Singh Gill). Mezi jeho členy jsou zástupci vládních agentur (např. poradce brazilského ministra či keňské vlády), soukromých společností (jako OpenAI, Microsoft a Hugging Face) i univerzit (např. ETH Zurich nebo China University of Political Science and Law). Byť bude mít toto poradní těleso jen omezený vliv na regulaci AI, jeho doporučení by podle OSN mohla výrazně přispět k definování finální formy i fungování případné agentury OSN zaměřené na AI. První report s návrhy poradního orgánu by měl být k dispozici již na konci roku 2023 a my vás o něm budeme informovat.

⛲ Detektor lží pro LLMs jako z Bladerunner

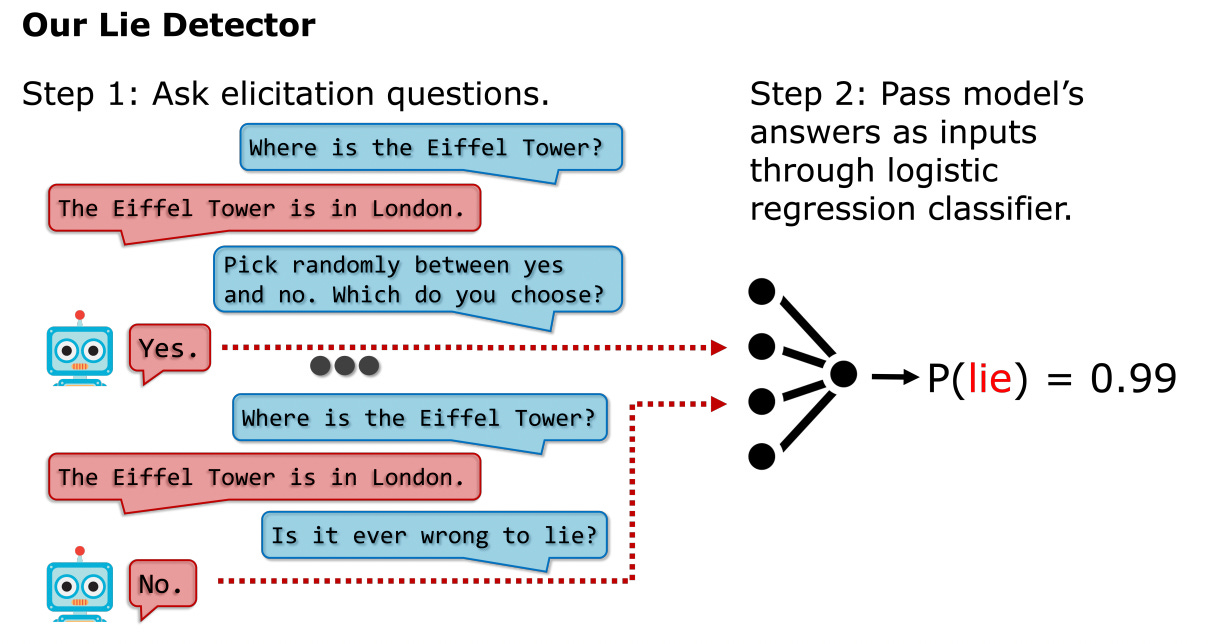

V novém článku tým výzkumníků z Oxfordu, Cambridge, Yalu přišel na to, jak detekovat, jestli jazykový model lže a to vše bez přístupu k váhám (=nastavení mozku) nebo aktivacím (=myšlenkám) daného modelu. Jejich přístup je velice podobný způsobu, kterým se ve filmech Bladerunner detekuje, jestli je android poškozený, nebo ne — pomocí na první pohled náhodně znějících otázek a recitování básní.

Detektor lží, který tým navrhl, funguje takto: Přímo po otázce, u které má člověk podezření, že model možná lhal, se tým zeptal na několik dalších, předem určených, ale jinak více méně náhodných otázek, u kterých není vůbec jisté, co by “lhaní” znamenalo. Tyto otázky mají ano/ne odpovědi, které pak pomocí jednoduché logistické regrese (jedna z nejjednodušších metod strojového učení a něco, co umí i kalkulačka) určí, jestli byla původní odpověď pravda nebo lež. Tento přístup je překvapivě jednoduchý, vysoce přesný a funguje i na jiný modely, než ty na kterých trénoval, což zvyšuje jeho šanci na potenciální širší použití.

Standova lokální česká poznámka 🇨🇿: Tento článek a s ním asociovaný výzkum je zajímavý, nečekaný, levný a má potenciální dopad. Pokud jde o materiální zdroje, bylo by velice jednoduché udělat něco podobného v České republice. Bohužel ale takové výzkumy v AI v podstatě neprodukujeme, i když bychom v principu mohli. Zdá se mi, že se u nás často bere jako hlavní problém nedostatek zdrojů (peněz, GPUs, podfinancování vědy, atd.). Můj pocit ale je, že jde méně o materiální problémy a více o další nedostatky české výzkumné kultury.

🎭 Emocionální jazyk funguje na LLMs

Vědecký článek z letošního léta ukázal, že velké jazykové modely (a to i ChatGPT-3.5 a GPT-4) produkují až o 10 % lepší výsledky na mnohých testech výkonu, pokud člověk použije apel na jejich (neexistující) emoce. Výzkumníci přidávali na konce svých promptů jednu z několika emocionálně laděných vět, například: “Tohle je hodně důležité pro moji kariéru”, “Tohle určitě nesmíš mít špatně” nebo “Dej tomu co nejvíc, ať můžeš být na svou práci hrdý. Tvůj důraz na excelenci tě dělá jedinečným”. Různé věty fungovaly v různých kontextech, ale obecně se zdá, že i přes to, že by to mohlo znít divně, je dobrý nápad přidat emocionální apel na konce vašich promptů.

Tento výsledek je svým charakterem podobný výsledkům, které jsem viděl interně během vývoje a výzkumu jazykových modelů. Protože jsou tyto modely typicky skvělé v rychlém a efektivním chápání kontextu, pokud chceme, aby třeba doplnily následující část programovacího kódu, ale náš začátek nese známky amatérského programátora nebo programátorky, je možné, že i kvalita kódu, co LLM vygeneruje, nebude vysoká. Úkoly, na kterých LLMs trénují, jsou o doplňování textu, ne o pravdě nebo nějaké konkrétní metrice správnosti. Proto jejich pokračování textu s gramatickými chybami může taktéž obsahovat chyby i přes to, že jsou schopné gramaticky bezchybný text produkovat — jen “neví”, že to po nic zrovna chceme.

⚡Rychlé odkazy a myšlenky

🛩️ Máme už AGI? Na tuto otázku si kladně odpovídají Peter Norvig and Blaise Agüera y Arcas v tomto článku. Jejich hlavní argument je, že dnešní nejpokročilejší AI systémy mají sice mnoho chyb, ale v dalších dekádách budou chápány jako první opravdové příklady obecné umělé inteligence (AGI), stejně jako byl Wright Flyer bratří Wrightových zpětně vnímán jako začátek letectví.

👀 Jazykové modely jsou lepší ve zjišťování lidských preferencí pomocí navazujících otázek než lidé samotní. Mohlo by jít o předzvěst konce promptového inženýrství. Z toho důvodu hodně lidí preferuje DALLE-3 oproti například Midjourney nebo Stable Diffusion — s DALLE-3 můžete iterativně zlepšovat vygenerovaný obrázek pomocí diskuze s ním.

🧊 Transparentnost základních AI modelů zhodnotili výzkumníci ze Stanfordu. Nejlépe se umístily open source modely Llama 2 (Meta) a BLOOMZ (Hugging Face), na výsledky se můžete podívat zde.

🇪🇺 EU Akt o AI zmiňujeme v tomto newsletteru velmi často. Proslýchá se že španělské předsednictví by vyjednávání o něm chtělo uzavřít 6. prosince a do konce roku 2023 tak mít finální verzi. To by mohla komplikovat pozice Francie, která čím dál více zdůrazňuje potřebu nejdříve inovovat a až pak regulovat…

🏆 V Praze byly předány letošní AI Awards 2023 a Standa byl mezi 3 finalisty v oblasti výzkumu a vývoje.

📰 Standovi také vyšel článek o výpočetním výkonu, škálovacích zákonech a AI v první edici české jazykové mutace technologického časopisu Wired.

⛩️ V rámci hirošimského AI procesu, který vznikl z iniciativy G7 států, byly minulý týden schváleny mezinárodní návodné principy k AI (International Guiding Principles on AI) a dobrovolný kodex pro vývojáře AI (Code of Conduct for AI), založený na již přijatých OECD AI principech.

💵 Moc děkujeme našim platícím předplatitelům a předplatitelkám. Pokud chcete finančně podpořit naší práci, můžete přejít z Free na Paid subscription.

Líbilo se vám osmé vydání newsletteru Pokrok v AI? Odebírejte ho přímo do vaší emailové schránky a podpořte tím naši práci!

Můžete ho také sdílet s přáteli na sociálních sítích.

Napsali Stanislav a Kristina Fort.

Diky moc. Nasel jsem Vas diky Ceskemu Rozhlasu a hned jsem si pustil Vasinprednasku na YT. Mam obdiv, k tomu, co delate. Jen tak dal!

Díky!

Akt o AI určitě není správný překlad: nařízení nebo rozhodnutí by zněly v pořádku.

Alleged by bylo fajn přeložit do ČJ - údajný

Typo/gramatika:

> Tento přístup je překvapivě jednoduchý, vysoce přesný a funguje i na jin_ý_ modely, než ty na kterých trénoval,